|

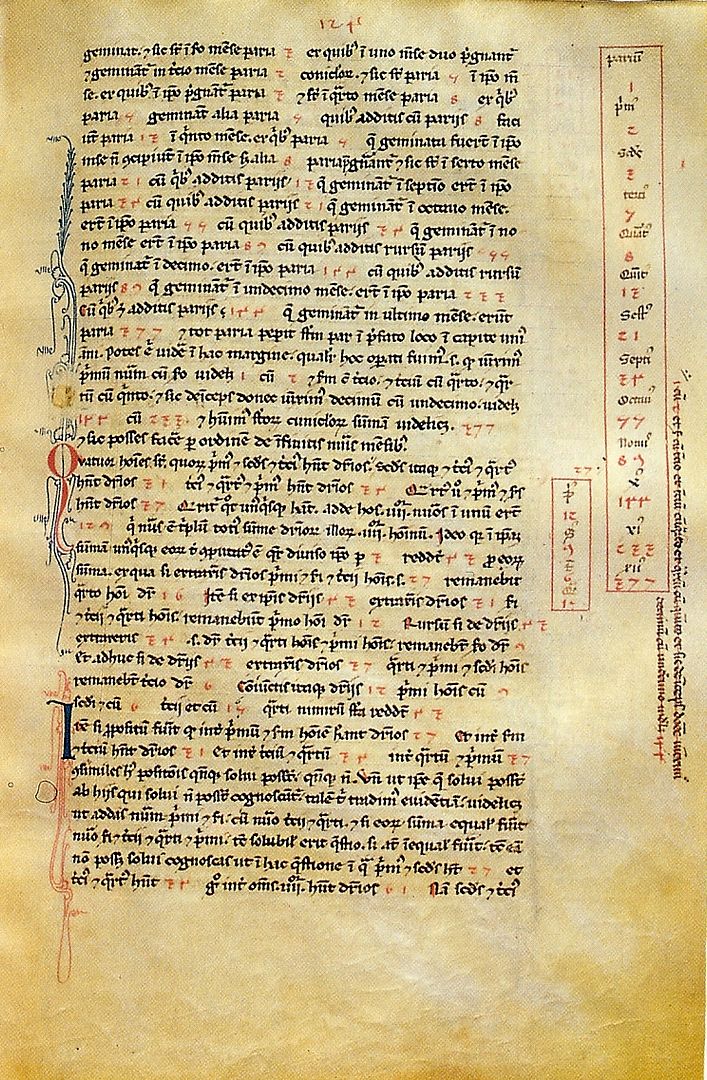

| Página del Liber abacci de Leonardo Pisano "Fibonacci" |

Todos, en mayor o menor medida, estamos

familiarizados con el simbolismo matemático. En un país mínimamente

desarrollado es difícil encontrar a alguien que no sepa qué

significan estos cinco símbolos en este orden: 2+1 = 3. De hecho, la

presencia del simbolismo matemático es tan común, efectiva y

eficiente que ni nos paramos a pensar que durante buena parte de la

existencia de la humanidad no existió. Ni siquiera durante la mayor

parte de la historia de la escritura. Y es que el simbolismo

matemático es un invento progresivo, con avances y retrocesos, y que

no toma carta de naturaleza plena hasta el siglo XVII. Europa será

el crisol donde se obtenga.

El uso de símbolos para representar

ideas matemáticas es lo que caracteriza a una rama de éstas que

conocemos como álgebra. En una expresión algebraica como

x3-ax2+10x-1

= 5

podemos distinguir tres tipos de

símbolos: por una parte los que representan cantidades conocidas

(10, 1, 5) o dadas (a), por otra los que representan

cantidades desconocidas o incógnitas (en este caso x) y,

finalmente los que expresan operaciones o relaciones (3,

2, +, -, =). En puridad, existe un cuarto simbolismo que

es posicional, es decir, cómo cambia el significado de un símbolo

por la posición con respecto a los demás, pero en lo que sigue no

nos referiremos a él explícitamente y nos concentraremos en el

origen de los otros tres tipos.

Muchas civilizaciones anteriores a la

griega, particularmente la babilonia y la egipcia, tienen textos

matemáticos. Suelen ser tablas contables, de control de producción

agrícola o de medida de terrenos, aunque alguno hay de lo que parece

entrenamiento en cálculo. Todos estos textos tienen en común que

describen los problemas literariamente y que el sistema de numeración

se basa en la repetición de símbolos. Estos textos emplean el mismo

sistema de escritura durante, literalmente, miles de años sin

cambios sustanciales. Ello nos hace ver que cumplían con las

necesidades de escribas, almaceneros, agrimensores y cobradores de

impuestos. O, visto de otra manera, no existía una necesidad de

abstracción matemática que favoreciese la aparición de una forma

más eficiente de representar las relaciones entre cantidades.

Hay que esperar a la era imperial

romana para encontrar un avance realmente significativo, aunque sea

de manos de un griego. Los griegos representaban las cantidades

numéricas empleando letras, pero Diofanto, probablemente en el siglo

III de la era común, da un paso más en el simbolismo en su

Aritmética, la misma que Fermat estudiaba cuando se le

ocurrió su famoso último teorema. Introduce abreviaturas para las

expresiones más habituales así como una notación especial para la

incógnita y las distintas potencias de la incógnita. El gran paso

hacia la abstracción matemática de Diofanto fue crear una

abreviatura para “igual a”, lo que constituye un paso fundamental

desde un álgebra verbal, descriptiva, hacia un álgebra simbólica y

abstracta.

A pesar de sus carencias (sólo existe

una incógnita, no existe notación para un número general conocido,

etc.) Diofanto consigue separarse de la geometría como único modo

de expresar los conceptos y operaciones matemáticos.

Tras Diofanto se entra en los años

oscuros donde prácticamente no existen avances. Habitualmente, los

libros de historia, y algún conferenciante TED, citan los trabajos

de los árabes como transmisores de la cultura grecolatina y, por

tanto, de las matemáticas. Hay muchos que piensan en la labor

realizada por los traductores en Castilla como fundamental. Y,

efectivamente, esto es así, pero no para el avance del simbolismo

algebraico, que retrocede a épocas anteriores a Diofanto, con un

retorno a la literalidad y la geometría. En el 1800 a.e.c. los

babilonios resolvían ecuaciones cuadráticas expresadas en forma de

texto; tres mil años después, a comienzos del siglo XII e.c., Omar

Jayam sigue haciéndolo igual.

La conexión con el conocimiento

musulmán existe pero es diferente a la que habitualmente se cree.

Fueron los intereses comerciales de Leonardo Pisano, más conocido

como Fibonacci, y sus viajes por el Mediterráneo, particularmente a

Egipto, donde habría entrado en contacto con las ideas matemáticas

persas e hindúes además de las musulmanas, los que trajeron una

revolución a Europa en forma de libro.

El Liber abacci (1202) de

Fibonacci probablemente tenga uno de los comienzos más

revolucionarios de la historia de la ciencia. Comienza tal que así:

“Hay nueve figuras de los indios: 9,8,7,6,5,4,3,2,1. Con estas nueve figuras, y con el signo 0 que en árabe se llama zephirum, se puede escribir cualquier número, como se demostrará.”

Los siguientes 7 capítulos del libro

(de un total de 15) se dedican a explicar cómo usar y realizar

operaciones con estos nuevos numerales.

Fibonacci aporta un avance fundamental,

como vemos, que facilita la aritmética enormemente. Pero sigue

habiendo limitaciones importantes. Fibonacci usa un sistema

sexagesimal para expresar sus resultados. La fundamental, sin

embargo, es que para incógnitas y operaciones Fibonacci también

sigue a los musulmanes aunque traduciéndolos al latín italianizado.

Así aparecen radix (raíz), res/causa/cosa (para la

incógnita), census (propiedad, para el cuadrado), o cubus

(cubo). Los problemas se siguen expresando literariamente.

Los desarrollos son muy lentos y, si

bien los nuevos numerales indo-arábigos se popularizan rápidamente,

hay que esperar hasta 1494, a la Summa de Luca Pacioli, para

registrar un nuevo avance, que parece un retroceso. Pacioli vuelve a

un sistema parecido al que Diofanto usó más de mil doscientos años

antes, usando los numerales de Fibonacci y expresando la incógnita

como co, su cuadrado como ce y el cubo como cu,

simples abreviaturas de los nombres italianos.

Se

producen algunos avances menores más, pero el sistema de Pacioli es

tan eficaz para el uso habitual que será necesaria una crisis

matemática para provocar el siguiente paso adelante en la notación

simbólica. Y esa crisis será la resolución de la ecuación cúbica.

Diofanto

y Cardano ya asumían la existencia “operativa” de los números

negativos. Cardano atribuía la misma operatividad de facto

a los complejos, pero para Rafael Bombelli que atacaba la resolución

de ecuaciones cúbicas irreducibles y llegó a dar reglas de signos

para la operación con números complejos, la notación disponible

era una tortura. Bombelli se ve forzado a la introducción del

corchete en su obra l'Algebra

(1572):

Multiplichisi, R.c.[2 più di meno

R.q.3] per R.c. [2 meno di meno R.q.3]

donde

R.q. y R.c.

son, respectivamente, la raíz cuadrada y la raíz cúbica.

El

simbolismo moderno estaba a punto de surgir de pura necesidad. Los

avances en trigonometría y sobre todo en álgebra requerían una

forma más racional de expresar ideas matemáticas. Y este avance se

dio en dos pasos gigantescos. Pero esos pasos se darían en Francia,

que se convertiría en los siguientes siglos en el centro de las

matemáticas.

El

primero lo supuso la publicación de De artem analyticem

isagoge en 1591 por parte de

François Viète. En honor a la verdad, este libro fue un gran paso

adelante y uno pequeño hacia atrás. Adelante porque en él se

emplean de forma sistemática letras para representar números. Si

bien esta idea se puede remontar a Diofanto, Viète va más allá y

distingue rangos de letras y sus aplicaciones. Las cantidades podían

ser de dos clases: “cosas buscadas” (quaesita)

y “cosas conocidas” (data).

Las incógnitas se escribían usando vocales mayúsculas A,E,I,O,U,Y

y las constantes con consonantes también mayúsculas B,C,D,F,... Por

ejemplo, en simbolismo de Viète la ecuación

bx2+dx = z

pasa a

ser

B in A quadrum, plus D plano in A,

aequari Z solido

Este

ejemplo también ilustra el paso atrás que mencionábamos antes, que

es un retorno a la geometría que se expresa a través de la “ley

de homogeneidad”, según la que todos los términos de la ecuación

deben tener las mismas dimensiones. Como bx2

tiene tres dimensiones, dx también debe tenerlas

(de ahí lo de D plano) al igual que z. Esto hace la

notación tediosa y aparentemente poco operativa, si bien Viète

manejaba polinomios de grado 45 con soltura.

Y entonces llegó La géométrie

de René Descartes en 1637. Este libro es el primero que se lee como

un texto moderno de matemáticas. Descartes toma todos los

conocimientos existentes sobre simbolismo matemático, los

simplifica, los racionaliza y los emplea en un libro que marca el

comienzo de la geometría algebraica. Sólo dos cosas importantes

están ausentes: el signo = para la igualdad y, paradójicamente, los

ejes cartesianos, y es que Descartes no veía la necesidad de que los

ejes estuviesen a 90 grados.

En La géométrie las letras

minúsculas del comienzo del alfabeto representan datos conocidos, y

las letras del final del alfabeto las incógnitas buscadas. La x

se convirtió en la representación de la incógnita por antonomasia

porque Descartes le dio libertad a su impresor de usar la letra del

final del alfabeto que más le conviniera, eligiendo éste la x

porque es la que menos uso tiene en francés.

A partir de este momento se produce una

triple revolución en las matemáticas: la generalización de la

impresión de libros, el uso de un simbolismo potentísimo y la

posibilidad de reducir la geometría a álgebra supondrán un

florecimiento tal, que en sólo cincuenta años después de La

géométrie se publicaba, por ejemplo, los Principia mathematica de

Newton.

La historia aquí presentada es muy

esquemática y existen matizaciones y adiciones muy interesantes que

se podrían hacer. Pero me temo que quedarán para otras entradas.

Esta entrada es una participación de Experientia docet en la Edición3'141592 de Carnaval de Matemáticas que acoge ZTFNews.