El 15 de

abril de 2010 volvía a casa después de asistir a una demostración

de un nuevo equipo industrial en una ciudad del centro de Suecia.

Cuando llegamos mi compañero y yo al aeropuerto de Estocolmo nos

encontramos con el caos. Al parecer un volcán en Islandia, el

Eyjafjallajökull, había entrado en erupción y las cenizas que

arrojaba a a la atmósfera obligaban a cerrar el espacio aéreo por

tiempo indefinido. Nuestro vuelo a Madrid aún no estaba cancelado

aunque sí muchos otros. Yo, siguiendo un instinto de supervivencia peculiar, entré en la bien surtida librería a comprarme un par de

libros.

Nuestro vuelo fue el último en

despegar de Estocolmo antes del cierre del espacio aéreo sueco y

nuestro piloto nos llevó a España dando un rodeo por Polonia. En

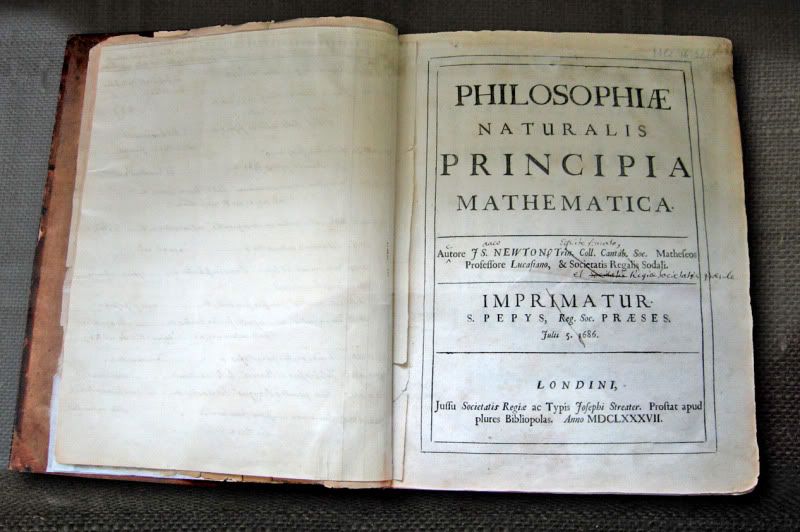

ese tiempo comencé a leer uno de los libros que más me ha hecho

pensar en los dos últimos años: The Black Swan, The Impact of

the Highly Improbable, de Nassim Nicholas Taleb.

Un cisne negro, citando a Taleb, es un

acontecimiento que reúne tres características. Primero, es

completamente inesperado, ya que nada en el pasado puede apuntar de

forma convincente a esa posibilidad. Segundo, tiene un impacto

enorme. Tercero, a pesar de ser inesperado, nuestra capacidad humana

para la racionalización a posteriori hace que lo veamos como

algo explicable y predecible.

Los cisnes negros son el tipo de

acontecimientos que marcan las revoluciones científico-técnicas; pensemos en el descubrimiento de los rayos X o en la penicilina o, y

perdonad que aquí cite una afición, los cuasicristales. En las

próximas décadas serán los cisnes negros los que marquen la

evolución de la ciencia y la técnica concretas. Por definición no

podemos saber cuáles serán. Nosotros, en lo que sigue, no vamos a

intentar predecir qué desarrollos concretos habrá en la ciencia y

la técnica en lo que queda de siglo, ya dejamos a otros que se

equivoquen en eso, sino que vamos a explorar brevemente, y sin ánimo de ser exhaustivos, las áreas en

las que podrían producirse esos avances. Puede que te sorprendan.

La instrumentalización de la

química y el recorrido limitado de la física.

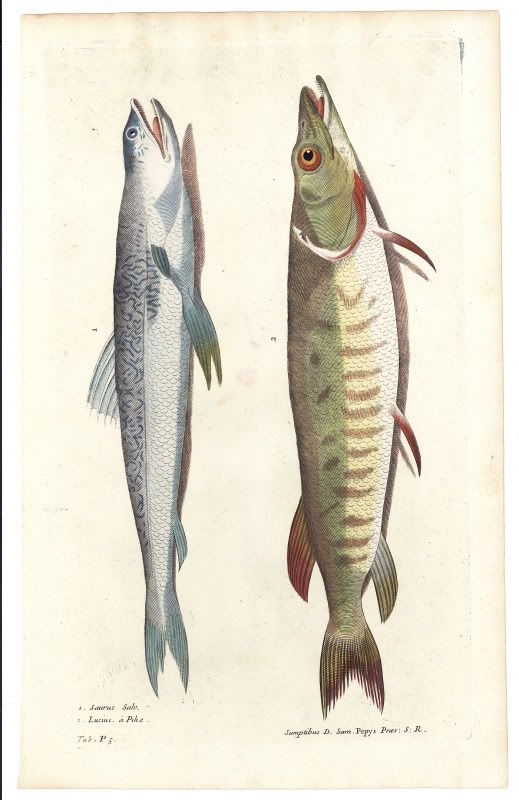

La química, como ciencia que permite

conocer el universo, está agotada. No habrá sorpresas químicas

relevantes, si bien cabe esperar de ella una enorme variedad de

contribuciones prácticas. La química es como una lengua que cuesta

dominar: a lo largo de los siglos hemos ido aprendiendo su gramática,

su vocabulario, sus modismos, cada uno de estos descubrimientos

permitiéndonos conocer más el universo y a nosotros. Pero un

idioma, una vez dominado, sirve para expresar ideas. Este es el

futuro papel de la química, un instrumento sofisticado que

facilitará mucho de lo que sigue.

La física sólo es un poco más

estimulante desde esta perspectiva que hablamos. Aunque aún haya

mucho que aprender acerca de la estructura fundamental del universo,

las máquinas necesarias para realizar esta exploración son cada vez

más grandes y caras. Existe un concepto económico crítico para

estas situaciones, el de rendimientos decrecientes y, aunque el

descubrimiento de una partícula compatible con el bosón de Higgs

pueda estimular durante un tiempo breve el imaginario colectivo de

los que administran el dinero, no cabe esperar muchas inversiones en

algo que tiene de entrada pocas aplicaciones prácticas desde su

punto de vista.

En las próximas décadas, salvo

hallazgos no previstos en el modelo estándar que nos depare el LHC

(más improbables si la partícula descubierta se confirma que,

efectivamente, es el bosón de Higgs del modelo estándar), la física

fundamental estará centrada en comprender la materia oscura

(partículas fundamentales que interactúan con la de materia

ordinaria aparentemente sólo a través de la gravedad) y en

encontrar ondas gravitacionales (lo que permitiría unir la gravedad,

explicada actualmente por la torre de marfil que es la teoría

general de la relatividad, con la física cuántica que explica el

resto de la física). Para conseguir ambos fines bastarían en

principio instrumentos relativamente baratos comparados con un

megaacelerador de partículas lineal, por ejemplo.

La otra gran incógnita de la física

es la energía oscura, eso que hace que el universo se expanda

aceleradamente. A diferencia de las dos anteriores, su resolución

requiere de una revolución teórica previa más que de nuevos datos.

Y esto entra de lleno en el dominio de los cisnes negros. Puede que

ahora, mientras lees esto, un parado esté garabateando, en un parque

de Málaga, la que podría ser la solución a este problema.

La revolución nanobiomática.

Para el año 2050, parece bastante

probable que sepamos, más allá de la certeza estadística, que la

vida es abundante en el universo. El estudio de los planetas

extrasolares con nuevos telescopios espaciales parece que es algo que

tiene la financiación poco menos que garantizada: la pregunta de si

estamos solos en el universo es fácilmente entendible por los

administradores y también interesante para ellos.

Un aspecto relacionado es el origen de

la vida en la Tierra. La respuesta puede que venga del mejor

conocimiento del funcionamiento celular y la identificación de sus

partes más primitivas, y de la experimentación, es decir, de la

creación de organismos vivos en el laboratorio a partir de moléculas

químicas sencillas.

Pero los descubrimientos en biología

están entrando en una fase exponencial que nosotros atribuimos a

cuatro motivos principales:

La capacidad desarrollada

recientemente de secuenciar el ADN rápidamente y en cantidades

enormes.

Las mejoras en microscopia, en el

sentido más amplio, desde sistemas de tinción a fotografías a

nivel atómico, que permiten una mejor comprensión de los procesos

celulares.

Las técnicas para el estudio

específico del encéfalo y su funcionamiento, probablemente el

objeto de estudio científico más interesante del universo.

La asunción generalizada de que

la investigación biológica tiene que tener una perspectiva

evolutiva.

Cabe esperar que en próximo par de

décadas la caracterización genética de todas las especies esté

completa. Alrededor del año 2030, dependiendo de la financiación,

la mayor parte de la vida conocida habrá sido caracterizada,

incluyendo la microbiológica marina o la subterránea profunda (de

existir). En el proceso es posible que nos encontremos grandes

sorpresas (asumimos que con más fundamento que la vida basada en

arsénico).

Lo anterior, completar el álbum de

cromos de la vida terrestre, es fascinante e intelectualmente

atractivo. Pero esta base de datos genéticos gigantesca y el

conocimiento biológico derivado de ella, abriría la puerta a la

explotación industrial, lo mismo que ocurrió con la química en el

XIX. En esto trabajan ya activamente personas como

Craig Venter, ya sea por la vía de crear de vida sintética de

diseño, ya por la creación de nuevos organismos transgénicos o

directamente por el uso de nuevas especies.

Pero, sin duda, el punto de inflexión

lo marcará la combinación de la biología con la nanociencia y la

informática: la nanobiomática.

Digámoslo claramente, y citando a un

sabio malagueño: la nanotecnología ha tenido un arranque de caballo

andaluz y un parón de burro manchego. Durante los últimos veinte

años se ha hablado mucho de nanotecnología pero, a fin de cuentas,

salvo algunas estructuras que quedan muy espectaculares en fotografía

y la alteración de las propiedades de algunos materiales, ya sea por

la incorporación de otros o por técnicas de encapsulación, poco

más se ha conseguido. Estamos a años-luz de esos ejércitos

colaborativos de micromáquinas que prometían los visionarios de los

años noventa. Pero esto cambiará cuando se conozca mejor el

comportamiento de las células.

Las proteínas, el ARN o el ADN son

moléculas grandes y tienen exactamente el tamaño típico de los objetos con los que opera la nanociencia: mayor que el de la química tradicional, pero aún suficientemente pequeños como para que la influencia de las interacciones supramoleculares electrostáticas sea crítica impidiendo que la ingeniería mecánica clásica pueda lidiar con

ellas. De hecho, fueron estas interacciones las que arruinaron las

predicciones de los visionarios: los engranajes y levas de las

micromáquinas se veían alterados por las fuerzas de van der Waals y

otros efectos mal comprendidos.

Pero, hete aquí que los sistemas

vivos, obviamente, funcionan. Una vez que se analicen apropiadamente

aparecerá todo un abanico de aplicaciones tecnológicas: ya sean

organismos altamente modificados, o sistemas completamente

artificiales que simplemente toman sus fundamentos de la biología,

como los robots de Karel Capek, el inventor del término en 1921.

Pero unos robots así requerirían

también la intersección de la biología, además de con la nanotecnología, con la informática y la

inteligencia artificial, lo que hemos dado en llamar nanobiomática. La unión de una mejor compresión del

funcionamiento del cerebro con una capacidad de computación

artificial mucho más sofisticada. Las nuevas técnicas para el

estudio del cerebro pondrán de manifiesto cómo se organiza el

cerebro a nivel celular (conectoma). Los ordenadores, más rápidos y

potentes, permitirán modelar como software esa nueva información.

Así sabremos cómo funciona el cerebro de verdad, lo que permitirá

la construcción de cerebros artificiales que trabajarán con los

mismos principios, pero mucho más potentes y sin errores. Cerebros

artificiales nanobiomáticos que puede que funcionen conscientemente.

Curiosamente, según la teoría de

Taleb, nadie podrá hacer una fortuna apostando a nada de lo

anterior: lo previsible no es novedoso realmente. Y es que el futuro lo conformarán los cisnes negros.