En el mundo de la física las ideas de Max Planck fueron progenitoras de algunas de las aportaciones más importantes de Einstein. Planck fue el primero en afirmar que la energía no es continua, sino que está constituida por trocitos indivisibles llamados cuantos, una idea sobre la que Einstein se basó para afirmar que la luz también estaba formada por paquetes similares, hoy conocidos como fotones. Esta relación paterno-filial se extendió también al mundo académico: los dos hombres estaban muy próximos y el aliento de Planck fue una gran ayuda para la ciencia y la carrera de Einstein, ya que Planck adoptó un papel muy activo tanto en la promoción de la teoría de la relatividad como en conseguir que Einstein avanzase profesionalmente.

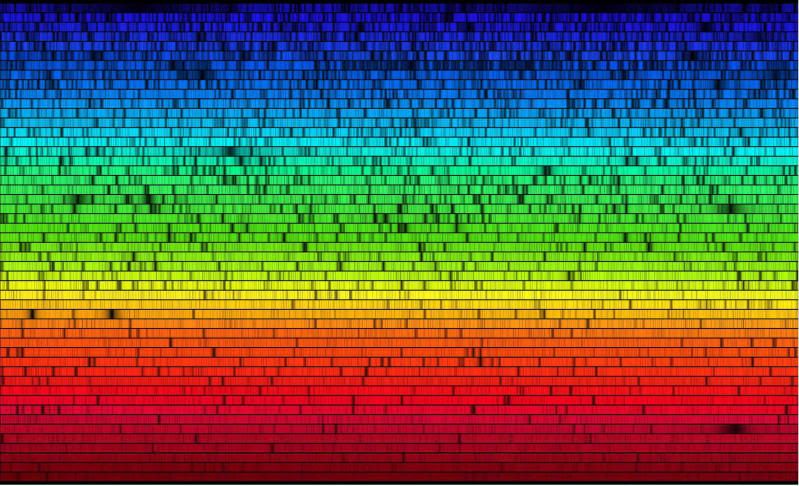

La principal contribución a la física de Max Planck llegó en 1901, cuando resolvió un problema conocido hoy como la “catástrofe del ultravioleta” (este nombre se lo dio Ehrenfest en 1911). Los físicos habían descubierto que cuando se trataba de luz y radiación las leyes de la mecánica clásica de Newton simplemente no servían. Un ejemplo es la llamada radiación del cuerpo negro. Un cuerpo negro es un cuerpo que absorbe toda la radiación electromagnética que incide sobre él que, a su vez, emite en forma de radiación térmica, cuyo espectro puede medirse. Pero la mecánica newtoniana predecía que las longitudes de onda ultravioletas deberían aumentar infinitamente, algo que no parecía probable y que los experimentos desmentían. Planck, que era muy creativo desde el punto de vista matemático, propuso una solución que partía de la hipótesis de que la luz sólo podía existir en paquetes específicos, cuantos, de energía. En vez de tener una onda continua de energía, como una onda sonora, Planck sugería que la energía era discontinua. La idea era parecida a una ola del mar que está compuesta por diminutas moléculas de agua, incluso si no son visibles al ojo humano. Una vez introducidos los cuantos la teoría modificada sí se correspondía con los datos experimentales de la radiación del cuerpo negro. La catástrofe del ultravioleta dejó de ser un problema, nacía la mecánica cuántica.

Pero Planck no sabía muy bien cómo interpretar esta nueva descripción de la radiación, o ni siquiera cómo esta innovadora técnica matemática podría ser aplicada a otra situación. De hecho llegó a decir que había introducido los cuantos en “un acto de desesperación”, por el que ganaría el premio Nobel en 1918. Pero fue un revolucionario reticente y no dio el siguiente paso: intentar averiguar qué significaba esta nueva idea.

Eso quedó para Einstein. Años después, Einstein recordaría que leyó el artículo revolucionario de Planck mientras estaba en la universidad y que dejó una profunda huella en él. Einstein se dio cuenta de que ninguna de las dos teorías fundamentales del momento, la mecánica newtoniana y la teoría electromagnética de Maxwell, describían exactamente el universo. Einstein empleó buena parte de los años siguientes en tratar de resolver este problema. Como consecuencia de este trabajo, en 1905, incorporó las ideas de Planck a una teoría completamente nueva de la luz. La teoría de Einstein decía que la luz visible, igual que la ultravioleta, estaba formada por cuantos. Este concepto fue el que terminó dándole el premio Nobel, pero también fue la teoría que tardó más tiempo en ser aceptada. Al principio, igual que la pasó a Planck antes que a él, Einstein no afirmaba rotundamente que estos “cuantos de luz” fuesen algo más que una herramienta matemática. Sin embargo, pasados unos años llegó a creer realmente que la luz estaba constituida por partículas igual que eran los electrones.

Es mérito de Planck haber sido uno de los responsables de que el novedoso artículo de Einstein se publicase. Planck era uno de los editores de la prestigiosa revista alemana Annalen der Physik. Llevaba su sección con una increíble apertura de mente: si un autor había publicado antes tenía prácticamente garantizado que podría volver a publicar en la revista, independientemente de lo que Planck opinase personalmente del trabajo. En este caso, a Planck no le gustaba demasiado la nueva teoría, pero movió hilos para que se publicase.

Einstein veía, como no podía ser de otra manera, las raíces de su trabajo en el previo de Planck, pero a Planck le llevó un tiempo poder aceptar la idea. Justo después de la primera Conferencia Solvay, celebrada en el otoño de 1911, Einstein escribió a un amigo: “He tenido bastante éxito a la hora de convencer a Planck que mi concepción [de los cuantos de luz] es correcta, después de su lucha en contra de ella de tantos años”. Si bien Planck terminó aceptando la existencia de los fotones, siempre mantuvo algo de distancia con la física cuántica que él había generado, dejando a sus colegas más jóvenes que trabajasen en los detalles.

Sin embargo, con la teoría especial de la relatividad Planck mantuvo una posición mucho más favorable y activa. El mismo año en que Einstein publicó su teoría de los cuantos de luz, también publicó su artículo sobre la teoría especial de la relatividad. Ese mismo otoño Planck ya daba conferencias sobre los detalles de la nueva teoría de Einstein. Planck era, ya en esa época, un científico de enorme influencia y para el joven Einstein contar con su apoyo fue un éxito importantísimo. En 1910, Planck fue aún más lejos en su apoyo a Einstein, llegando a compararlo públicamente con Copérnico, diciendo. “Este principio [de la relatividad] ha traído una revolución en nuestra representación física del mundo, que, en extensión y profundidad, solamente puede ser comparada con la que produjo la introducción del sistema copernicano”.

Y, con todo y como buen camarada, Planck no podía evitar mofarse educadamente de Einstein: tras leer un intento de éste de escribir un artículo de divulgación de la teoría de la relatividad dirigido al público en general, Planck dijo que Einstein parecía pensar que podía convertir una frase compleja en algo entendible simplemente introduciendo frecuentes interjecciones de “querido lector”.

Planck se convirtió en un defensor de las ideas y la persona de Einstein, llegando a extremos que rayan el heroísmo. Empezando por su carrera profesional, Planck ayudó a Einstein a conseguir un trabajo en los recientemente creados Institutos Kaiser Wilhem en Berlín, llegando a negociar en su favor para que le concedieran los aumentos de sueldo anuales. Planck también era secretario de la Academia Prusiana de Ciencias en la que se dedicaba a promover la ciencia alemana. Al aumentar el nacionalismo y el antisemitismo alemanes, Einstein le prometió a Planck, para entonces un íntimo amigo, que no abandonaría Berlín si no era absolutamente necesario.

Einstein terminaría abandonando Berlín y renunciando a su pertenencia a la Academia Prusiana en 1933, justo después de que se le otorgasen a Hitler plenos poderes sobre Alemania. Para entonces Planck tuvo que admitir que era “la única salida”, pero no se quedó callado como muchos de sus colegas. Permaneció en Alemania y mantuvo su posición en la Academia desde la que intentó desesperadamente contener los ataques contra la “ciencia judía” y los científicos judíos. Tras la marcha de Einstein en 1933, Planck continuó alabando en público su trabajo y a su persona, a pesar de haberse convertido Einstein en el objetivo principal de los ataques y del riesgo que ello suponía para el propio Planck y su familia: “Herr Einstein no es uno más entre muchos físicos sobresalientes, sino que Herr Einstein es el físico a través de cuyos ensayos, publicados en nuestra Academia, el conocimiento físico en este siglo ha sido profundizado de una manera cuya importancia sólo puede compararse con los logros de Johannes Kepler o Isaac Newton”. Planck, llegó a solicitar y conseguir entrevistarse con Hitler para intentar convencerle, sin éxito, de que su política contra los judíos perjudicaba el avance científico alemán.

Tras una vida de prestigio en Alemania, la Segunda Guerra Mundial fue, en lo personal, devastadora para Planck. Su hijo fue asesinado por la Gestapo por su participación en el intento de atentado contra Hitler de 1944. Otros tres hijos de Planck y su primera esposa habían muerto ya y este fue el mazazo final. Le quedaban aún se segunda mujer y el hijo de ambos, pero la vida dejó de interesarle. Moriría tres años después.

Si bien siempre fue un líder de la comunidad científica internacional, Planck no publicó ningún artículo relevante desde el de 1901. Sus escritos se volvieron cada vez más hacia la filosofía de la ciencia y a la descripción de cómo cambiaban las teorías científicas: “Una nueva verdad científica no triunfa porque convence a sus opositores y les hace ver la luz, sino más bien porque sus opositores terminan muriendo y una nueva generación crece familiarizada con ella”. Planck escribía esto en una época en la que otros filósofos estaban desarrollando ideas sobre cómo se desarrolla la ciencia, ideas que todavía perviven en el pensamiento filosófico actual, pero el principio de Planck parece que es especialmente relevante para la mecánica cuántica. Einstein y Planck fueron dos de los pocos físicos que levantaron su voz en contra de la nueva física, mientras que una nueva cosecha de veinteañeros la abrazaba con entusiasmo. Tras las muertes de Einstein y Planck, la mecánica cuántica que fundaron, pero siempre cuestionaron, se enseña, con la convicción de la teoría aceptada, a las nuevas generaciones de estudiantes.

[En la imagen, tomada en 1931 durante la visita de Millikan a la Academia Prusiana de Ciencias podemos ver, de izquierda a derecha, a Walther Nernst, Albert Einstein, Max Planck, Robert Millikan y Max von Laue; los cinco ya tenían el Nobel]