La experiencia enseña que es mucho más lo que desconocemos que lo que sabemos. También que muchas veces es más interesante el camino que el destino final y que lo verdaderamente revolucionario empieza con un “¡qué curioso!”.

lunes, 31 de mayo de 2010

¿Cómo alivia el dolor la acupuntura?

domingo, 30 de mayo de 2010

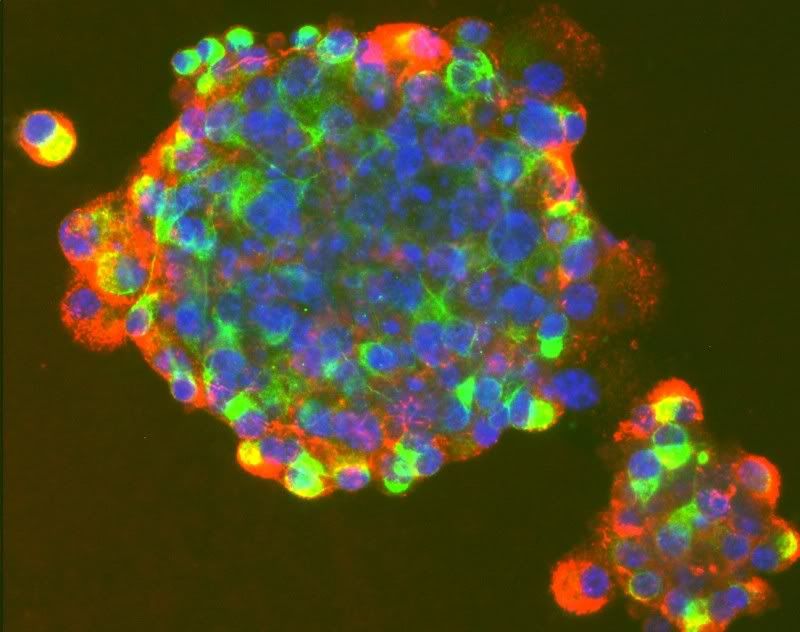

Vida artificial y biología sintética: una aproximación al estado del arte.

jueves, 27 de mayo de 2010

Los días de lluvia no deprimen.

martes, 25 de mayo de 2010

El nanofrío que viene.

Nanoesto, nanoaquello, nanolootro. La idea de que hacer cosas tan pequeñas que mides sus dimensiones en nanometros (milmillonésimas de metro) conlleve ventajas que no están al alcance de objetos mayores ha estado rondando durante una década. Lo suficiente como para que los escépticos se pregunten si algo útil saldrá alguna vez de estas nanocosas. Sin embargo, parece probable que algo útil esté a punto de salir.

Las pruebas indican que añadir una pizca de nanopartículas al agua mejora su conductividad térmica, y por lo tanto, su capacidad para evacuar calor de lo que esté en contacto con ella, ¡en un 60%! En un mundo en el que el coste de la refrigeración es una carga económica no pequeña (la refrigeración industrial consume el 7% de la electricidad generada en

La refrigeración por nanofluidos, como se conoce el fenómeno, se descubrió hace casi dos décadas, pero es ahora cuando comienza a salir del laboratorio. Un nanofluido no es más que una suspensión coloidal de nanopartículas en un fluido, en nuestro caso agua. Es el tipo de coloide que se llama sol, una dispersión de partículas sólidas en un medio dispersante líquido, como la tinta. El desarrollo de esta tecnología, aparentemente tan simple, no ha estado exento de dificultades.

La primera dificultad fue impedir la tendencia de las partículas a juntarse y dejar de ser nano. Eso se solucionó añadiendo agentes emulsionadores a la mezcla como el bromuro de cetrimonio (hexadeciltrimetil amonio), que se desarrolló originalmente como antiséptico.

El segundo problema era qué partículas usar. De momento parece que los óxidos de metales como el zinc (ZnO) y el cobre (CuO) están entre los favoritos, pero también se están estudiando las propiedades de la alúmina (Al2O3) y de los nanotubos de carbono (C). De aquí surge la pregunta de cuál es la base del funcionamiento de este fenómeno. No es solamente que el ingrediente añadido (el óptimo parece estar del 6 al 8% del volumen total) sea en sí mismo un buen conductor del calor, aunque eso ayude. Los nanofluidos son mejores conductores que la suma de sus partes. Esto sugiere que las partículas están cambiando la estructura misma del agua de forma que mejoran su conductividad. El agua, a pesar de no parecer tener estructura interna, la tiene, especialmente cuando está fría. Las moléculas están organizadas de forma que recuerdan a la estructura del hielo, pero más “sueltas”. Las nanopartículas alteran, inevitablemente, esta disposición y esto puede hacer a la mezcla más capaz de transmitir el calor. Si se conociesen estos cambios, escoger el tamaño y la composición de las nanopartículas sería un poco menos de ensayo y error.

El tercer problema es el paso del laboratorio a la escala industrial. Cuando las cantidades aumentan, la forma en la que los componentes se mezclan y reaccionan se altera significativamente. Esto hace que sea difícil predecir a partir de experimentos a pequeña escala que ocurrirá en una instalación comercial.

Si estos problemas pueden ser superados se anuncia un gran futuro, y parte de la nanomoda podría convertirse en un producto útil.

lunes, 24 de mayo de 2010

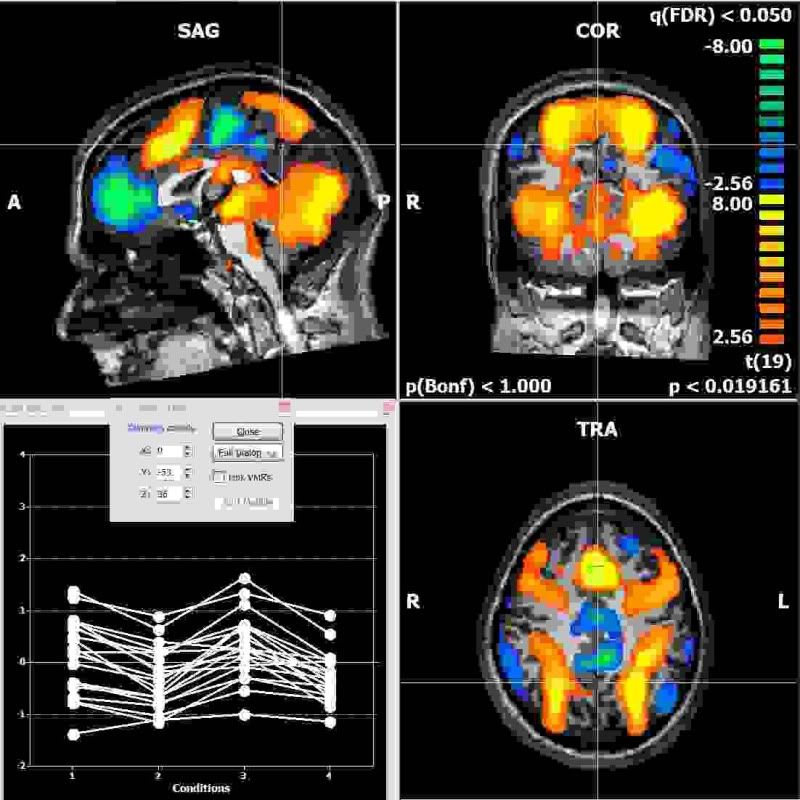

El escáner afecta al metabolismo del cerebro.

Una investigación realizada en el Instituto Nacional sobre el Abuso de Drogas y encabezada por Nora Volkow, pone de manifiesto que los escáneres por resonancia magnética funcional (fMRI) afectan al metabolismo de la glucosa por parte del cerebro. Este resultado, de enorme trascendencia, primero pone en cuestión los datos obtenidos por esta técnica en los últimos años, en segundo lugar pone de manifiesto que la fMRI no es inocua y, por último, abre la puerta a nuevos usos terapéuticos. El artículo se publica en NeuroImage.

Los autores se han planteado la más sencilla de las preguntas: "¿afecta el fMRI y sus cambios de gradiente al funcionamiento del cerebro?" Con cambios de gradiente nos referimos a la base del funcionamiento de estos escáneres: cambios rápidos del gradiente de campos magnéticos, que pueden generar campos eléctricos que, a su vez, podrían afectar a la actividad neuronal.

Es increíble que haya cientos de miles de artículos que usan la fMRI para obtener imágenes e investigar el cerebro y ninguno se haya molestado en investigar si el instrumento de medida afectaba al sistema que se iba a medir. Resulta que sí lo hace, y esto tiene implicaciones para la seguridad de su uso y para crear una nueva generación de escáneres/estimuladores combinados.

A lo largo de los años ha habido informes sobre la estimulación de los nervios periféricos con gradientes que cambian rápidamente, pero todo el mundo ha asumido (porque sí) que el fMRI no cambia la actividad del cerebro realmente. Incluso hubo un artículo en el que se afirmaba que algunas secuencias de MRI podrían cambiar el estado de ánimo y tratar la depresión.

La gran ventaja del fMRI para el estudio del cerebro es que es una técnica no invasiva y prácticamente en tiempo real. Volkow y sus colaboradores usaron una técnica más laboriosa y algo más invasiva para controlar el funcionamiento del cerebro con y sin el fMRI funcionando. Inyectaron a los 15 voluntarios sanos fluorodeoxy-D-glucosa, en la que el flúor era F-18, un radioisótopo que es una fuente de positrones (sí, antimateria), para monitorizar mediante tomografía por emisión de positrones (PET, por sus siglas en inglés) su distribución, que se correlaciona con lo que el cerebro hace en cada momento. Durante el tiempo de metabolización los voluntarios estuvieron dos veces en un escáner de 4 teslas, una vez apagado y la otra encendido.

Es decir, usaron PET para ver lo que estaba pasando en el cerebro durante el escáner fMRI y encontraron que había cambios en el cerebro asociados con el funcionamiento del escáner. Estos cambios eran proporcionales a la intensidad del campo eléctrico generado por los cambios de gradiente. El fMRI cambiaba el metabolismo (relativo) en las áreas correspondientes a los polos del cerebro: los córtex occipital inferior y frontal por un lado y parietal superior, por otro.

Las consecuencias tienen un alcance enorme. En cuestión de seguridad, ya no se puede asumir que el fMRI no afecta al cerebro. Ahora se hace necesario estudiar qué campos y gradientes son seguros y cuáles no. El estudio también sugiere que, si conseguimos comprender mejor cómo el fMRI causa los cambios en el metabolismo, se podrían crear máquinas de nueva generación, que por una parte podrían ser escáneres y por otra podrían ser estimuladores. Finalmente, los resultados obtenidos en la investigación en los que se veían implicadas las zonas afectadas por el funcionamiento del fMRI, pasan automáticamente a estar en revisión.

Referencia:

Volkow ND, Tomasi D, Wang GJ, Fowler JS, Telang F, Wang R, Alexoff D, Logan J, Wong C, Pradhan K, Caparelli EC, Ma Y, & Jayne M (2010). Effects of low-field magnetic stimulation on brain glucose metabolism. NeuroImage, 51 (2), 623-8 PMID: 20156571domingo, 23 de mayo de 2010

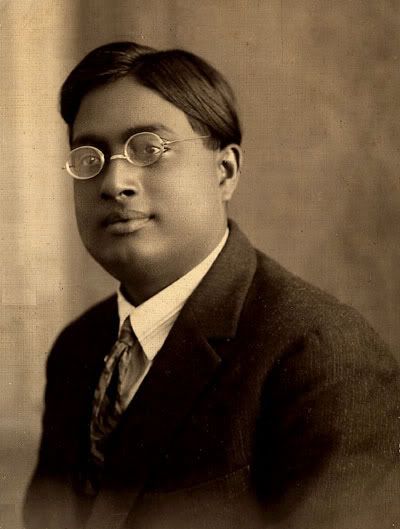

Einstein y...el condensado de Bose-Einstein.

En los años 20 del siglo XX, Albert Einstein amplió las ideas del físico indio Satyendra Nath Bose para predecir que, a temperaturas extremadamente frías, los átomos se unirían en una nueva fase de la materia (diferente a líquido, gas, sólido o plasma) conocida como condensado de Bose-Einstein.

En 1924, Bose vivía en Calcuta y no conseguía llamar la atención de sus colegas europeos sobre su trabajo. Se decidió a escribir a Einstein, adjuntándole un artículo que usaba una nueva forma de estadística para deducir la ley de Planck, la famosa ecuación que representa la intensidad de la radiación de un cuerpo negro como función de la temperatura. Einstein quedó impresionado con la mecánica estadística de fotones de Bose, calificándola como “una avance significativo”. Tradujo personalmente el artículo al alemán e intervino para que se publicase [1] en Zeitschrift Für Physik en 1924.

La nueva estadística de Bose ofrecía más información sobre cómo comprender el comportamiento de los fotones. Bose demostró que si un fotón alcanzaba un estado cuántico específico (un conjunto de variables que incluye la energía que tiene el fotón), entonces existía una pequeña tendencia a que el siguiente fotón alcanzase el mismo estado. Es como si cada vez que golpeases una bola de billar americano hubiese más probabilidad de que fuese a la tronera (bolsillo) donde ya hay una bola.

Bose había aplicado su estadística a un “gas” de fotones. Esto indujo a Einstein a considerar la aplicación de la estadística de Bose a un gas ideal de átomos o moléculas; Einstein quería ver qué pasaba cuando uno trataba con materia de verdad. Basándose en el trabajo de Bose, Einstein terminó deduciendo un conjunto de fórmulas que predecían cómo los átomos de un gas deberían comportarse, que resulta ser correcto para cierto tipo de partículas, entre ellas protones y neutrones, que ahora se conocen, apropiadamente, como bosones.

Como consecuencia de estas nuevas ideas surgía una predicción de lo que les ocurriría a los átomos a temperaturas extremadamente bajas, cercanas al cero absoluto. En 1925, Einstein descubrió que si a un gas se le baja la temperatura hasta aproximarla al cero absoluto, una temperatura a la que los átomos casi no se muevan, todos alcanzarán exactamente el mismo estado cuántico.

Volviendo a la mesa de billar, podemos imaginar que dejamos caer 20 bolas sobre la mesa y vemos cómo ruedan cada una hasta terminar en troneras diferentes. Esta clase de rodar aleatorio es lo que ocurre a temperaturas normales: cada átomo en un estado cuántico específico. Pero cerca del cero absoluto, esas bolas dejadas caer irían, una tras otra, a la misma tronera. En el cero absoluto, los átomos se “bloquean” en el mismo estado cuántico y van uno detrás de otro sin discusión. Se unen en un nuevo estado de la materia que se denomina condensado de Bose-Einstein. Todos los átomos en un condensado de Bose-Einstein pierden su identidad individual. Marchan al unísono, actuando como un solo superátomo. De hecho, los condensados de Bose-Einstein interaccionan entre sí como una partícula con otra: se repelen o atraen igual que los átomos individuales.

Einstein publicó su trabajo en dos artículos en 1925 [2][3], cuando tenía 46 años. No es habitual que un científico haga una contribución de este calibre en un campo completamente nuevo cuando ya tiene más de 40 años y, de hecho, esta fue la última gran contribución de Einstein a la física. Setenta años más tarde el condensado de Bose-Einstein fue observado experimentalmente en átomos de rubidio.

Referencias:

[1]

Bose, S.N . (1924). Plancks Gesetz und Lichtquantenhypothese Zeitschrift für Physik, 26 (1), 178-181 DOI: 10.1007/BF01327326

sábado, 22 de mayo de 2010

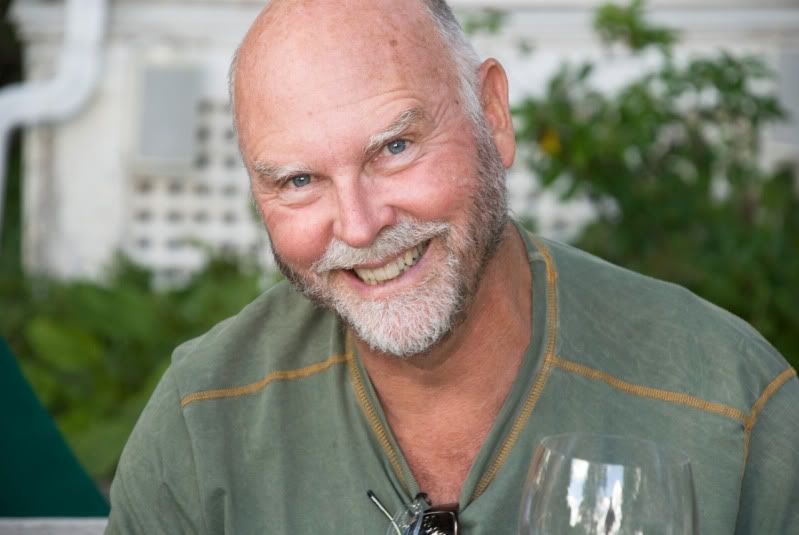

Venter o el nuevo Prometeo

viernes, 21 de mayo de 2010

La vida maravillosa continúa.

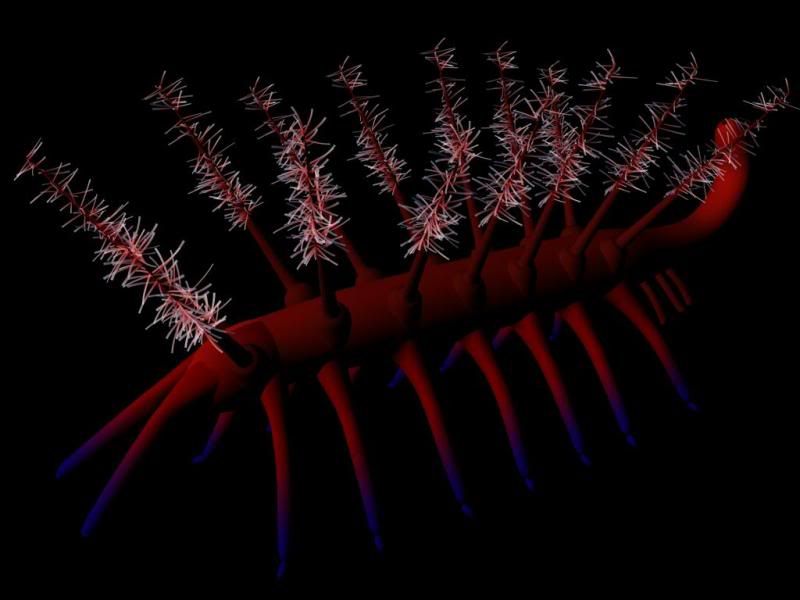

Algunos descubrimientos son tan inusuales que se emplean años, décadas y algunas veces siglos en comprender su significado completo. Uno de estos descubrimientos es un lugar llamado Burgess Shale, que contiene un registro fósil de las más extrañas criaturas que vivieron hace 505 millones de años. Fue descubierto en las Montañas Rocosas canadienses hace más de un siglo y se hizo famoso tras el libro "Wonderful Life" (Vida maravillosa) de Stephen Jay Gould. Durante mucho tiempo se ha creído que la curiosa fauna que vivió allí desapareció en una serie de extinciones basándose simplemente en que termina el registro fósil. Pero ya no parece que sea así.

Burgess Shale apareció poco después de un periodo conocido como la explosión del Cámbrico, en el que surgieron la mayoría de grupos de animales complejos en un intervalo de tiempo sorprendentemente corto. Hace más de 560 millones de años la mayor parte de seres vivos eran o bien células individuales o simples colonias de células. Entonces, por razones que continúan siendo un misterio, la vida se diversificó masivamente y se volvió aún más compleja ya que la tasa de evolución aumentó. Una característica inusual de Burgess Shale es que es uno de los estratos de fósiles más antiguos que contienen impresiones de las partes blandas de los animales. Uno de los secretos mejor guardados de la paleontología es que los fósiles no son un registro de la vida que existía en un determinado momento, sino un registro de la vida con huesos y conchas.

Aunque el estrato de fósiles se descubrió en una montaña, cuando estos animales estaban vivos merodeaban bajo un océano, cuyo lecho fue más tarde levantado por los movimientos tectónicos para crear las Montañas Rocosas. Nadie sabe exactamente por qué estaban tan bien preservados. Una posibilidad es que estas criaturas fueran enterradas rápidamente y en unas condiciones no apropiadas para la descomposición de las partes blandas del cuerpo por bacterias.

Los que trabajaron primero en Burgess Shale, desenterrando 65.000 especímenes durante un período de 14 años hasta 1924, dieron por sentado que los fósiles provenían de miembros extintos de grupos de animales que existen hoy día. Esto resultó ser una traba a la investigación, ya que las criaturas eran tan inusuales que todavía es difícil clasificarlas.

El Opabinia regalis, por ejemplo, tenía unos

El Nectocaris ptyrex, parecía poco más o menos una sanguijuela, pero con aletas y tentáculos.

El rey de la rareza era, sin duda, el bien llamado el pequeño (

Los paleontólogos han pensado durante mucho tiempo que los animales de Burgess Shale son ejemplos de experimentos de la evolución. En otras palabras, formas de vida completamente nuevas que no sobrevivieron o que llevaron a otros grupos o especies. Irónicamente, Hallucigenia, resultó ser la excepción que confirmó la regla. Hoy se piensa que fue un ancestro de los artrópodos modernos, que incluye cualquier cosa con un exoesqueleto duro, desde moscas y mariposas a ciempiés y cangrejos. Muchas otras de esas extrañas criaturas resultan ser caras familiares disfrazadas.

Ahora otro malentendido ha sido eliminado. En un artículo publicado en Nature por un equipo de investigadores encabezado por Peter van Roy de

Referencia:

Van Roy, P., Orr, P., Botting, J., Muir, L., Vinther, J., Lefebvre, B., Hariri, K., & Briggs, D. (2010). Ordovician faunas of Burgess Shale type Nature, 465 (7295), 215-218 DOI: 10.1038/nature09038jueves, 20 de mayo de 2010

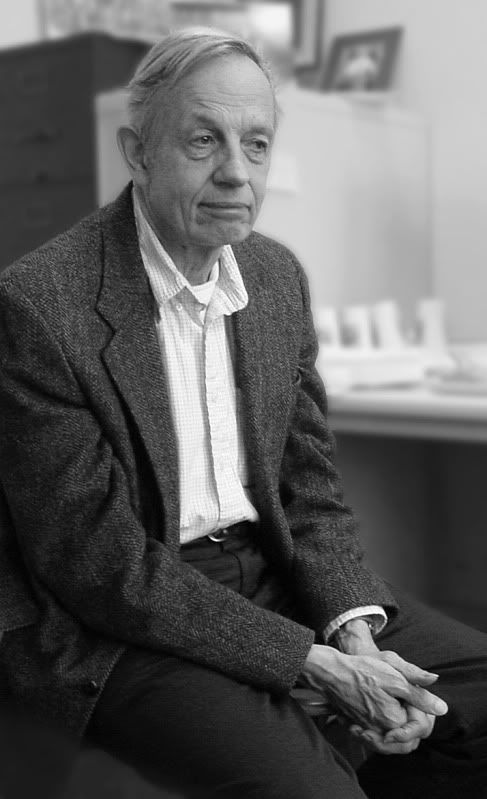

Enfermedad mental y creatividad: una base fisiológica común.

¿La esquizofrenia y la creatividad están relacionadas? Hay grandes creadores que han padecido esta enfermedad pero, ¿subyace alguna base neurológica común? Un estudio publicado en PloS ONE por un grupo de investigadores del Instituto Karolinska (Suecia) da una respuesta afirmativa: el sistema dopaminérgico en las personas muy creativas sanas es similar en algunos aspectos al de la gente con esquizofrenia.

Se ha demostrado que la creatividad es, de alguna manera, más frecuente en la gente que tiene antecedentes de enfermedad mental en la familia. La creatividad también está unida a un riesgo ligeramente mayor de esquizofrenia y trastorno bipolar. Algunos rasgos psicológicos, como la capacidad para hacer asociaciones inusuales y estrambóticas, son comunes a esquizofrénicos y personas sanas altamente creativas. Estos indicios de que había algo común a nivel fisiológico se ven ahora refrendados.

Los investigadores, encabezados por Örjan de Manzano, se centraron en el estudio de un tipo concreto de receptor de la dopamina, el D2. En concreto analizaron la densidad del receptor en el tálamo, en el estriado y en el córtex frontal mediante tomografía por emisión de positrones (PET, por sus siglas en inglés) en 13 voluntarios sanos que mostraron su capacidad creativa mediante un test de pensamiento divergente (la batería de “Inventiva” del Berliner Intelligenz Struktur Test).

Los resultados muestran que la gente altamente creativa, que obtuvo buenos resultados en el test de pensamiento divergente, tenía una densidad más baja de receptores D2 en el tálamo que la gente menos creativa. Se sabe que los esquizofrénicos también tienen una densidad baja de D2 en esta parte del cerebro, lo que sugiere que éste sería un indicio de que existe una causa neurológica para la conexión entre enfermedad mental y creatividad.

El tálamo tiene múltiples funciones. Se piensa que actúa de repetidor y filtro entre varias áreas subcorticales y el córtex cerebral. Cada sistema sensorial (a excepción del olfativo) incluye un núcleo talámico que recibe las señales sensoriales y las reenvía filtradas al área cortical asociada. Un menor número de receptores D2 en el tálamo probablemente signifique un menor grado de filtrado y, por tanto, un mayor flujo de información hacia las áreas responsables del pensamiento del córtex. Este podría ser el mecanismo que explique por qué tanto las personas sanas muy creativas como los esquizofrénicos ven muchas conexiones nada comunes en una situación de resolución de problemas.

Referencia:

de Manzano, Ö., Cervenka, S., Karabanov, A., Farde, L., & Ullén, F. (2010). Thinking Outside a Less Intact Box: Thalamic Dopamine D2 Receptor Densities Are Negatively Related to Psychometric Creativity in Healthy Individuals PLoS ONE, 5 (5) DOI: 10.1371/journal.pone.0010670martes, 18 de mayo de 2010

Cómo usar las redes sociales para la detección temprana de brotes de enfermedades contagiosas.

Lo más probable es que tus amigos sean más populares que tú. Esta es una de las características de las redes sociales que ya se conoce desde hace tiempo y recibe el nombre de "paradoja de la amistad". Para lo que sigue es importante entender este concepto, así que intentaremos ilustrarlo con un ejemplo.

Consideremos a una persona que suele dar fiestas, recibir amigos, y que conoce a cientos de personas y, por otro, a un misántropo con sólo uno o dos amigos. Estadísticamente hablando, una persona escogida al azar es mucho más probable que conozca al que da fiestas, simplemente porque tiene más amigos. En términos más formales la paradoja se puede expresar de la siguiente manera: los amigos de cualquier individuo aleatorio es más probable que estén en una posición más central de la red social que el propio individuo.

En un estudio colgado en arXiv y que será publicado en los Proceedings of the National Academy of Sciences, Nicholas Christakis de

En un ensayo llevado a cabo el año pasado, Christakis y Fowler monitorizaron la propagación tanto de la gripe estacional como de

Los investigadores seleccionaron un grupo aleatorio de 319 estudiantes y les pidieron a cada uno que nombrase hasta tres amigos. Con estos nombres se creó otro grupo de 425 amigos. Tal y como predice la paradoja de la amistad, los miembros de este segundo grupo eran más populares (eran nombrados más veces por el grupo aleatorio) y más centrales en la red de conexiones entre los estudiantes de Harvard. Los casos de gripe empezaron a registrarse desde el primero de septiembre del 2009 hasta el final de diciembre, identificando a aquellos diagnosticados por los servicios de salud de la universidad y por las respuestas por correo electrónico a una encuesta de salud enviada dos veces por semana.

En conjunto, el 8% de los estudiantes tuvieron un diagnóstico formal de gripe y otro 32% se había autodiagnosticado. No fue una sorpresa encontrar que la tasa de infección alcanzó un pico dos semanas antes en el grupo de los amigos más conectados. Sus contactos sociales estaban de hecho causando que se contagiasen antes.

Los investigadores querían dar un paso más, por lo que analizaron los datos buscando una señal de alerta del brote cuando se comenzaba a propagar. Compararon los diagnósticos entre los dos grupos, día a día, para los 122 días que duró el estudio. Se podía detectar por primera vez una diferencia significativa entre los dos grupos nada menos que 46 días antes de que se alcanzase el pico de visitas al médico en el grupo aleatorio. Para aquellos que se autodiagnosticaron, la diferencia era de 83 días antes del pico en los autodiagnósticos.

Estos resultados son impresionantes. Pero lo son aún más si se comparan con los obtenidos por los métodos en uso por los Centros para

El método de Christakis y Fowler es extrapolable, en principio, a cualquier contagio que se propague por una red social, sea biológico, psicológico, informativo o de comportamiento. Si empieza a emplearse de forma generalizada, ser popular se cotizaría todavía más.

Referencia:

Nicholas A. Christakis, & James H. Fowler (2010). Social Network Sensors for Early Detection of Contagious Outbreaks Proceedings of the National Academy of Sciences arXiv: 1004.4792v1lunes, 17 de mayo de 2010

Un método de computación analógico para la fuerza de Casimir.

El encontrar una solución a las ecuaciones de las fuerzas de Casimir es algo que va mucho más allá del mero conocimiento teórico: poder calcular las fuerzas de Casimir para distintas geometrías se ha convertido en algo imprescindible en nanotecnología. Dado que las fuerzas de Casimir pueden hacer que las partes móviles de los sistemas electromecánicos a nanoescala se queden pegadas, es necesario encontrar geometrías donde en vez de atracción haya repulsión, y esto es lo que permite la nueva técnica.

Eso sí, la creatividad humana está llamada a jugar un gran papel para encontrar estas formas con fuerzas repulsivas: todavía es necesario el uso de la intuición para imaginar qué formas pueden tener repulsión. La técnica de Rodríguez et al. solo nos dirá si estamos en lo cierto a posteriori.

[Esta es la participación de Experientia docet en el VII Carnaval de la Física, que este mes acoge El navegante.]

Referencia:

Rodriguez, A., McCauley, A., Joannopoulos, J., & Johnson, S. (2010). Theoretical ingredients of a Casimir analog computer Proceedings of the National Academy of Sciences DOI: 10.1073/pnas.1003894107domingo, 16 de mayo de 2010

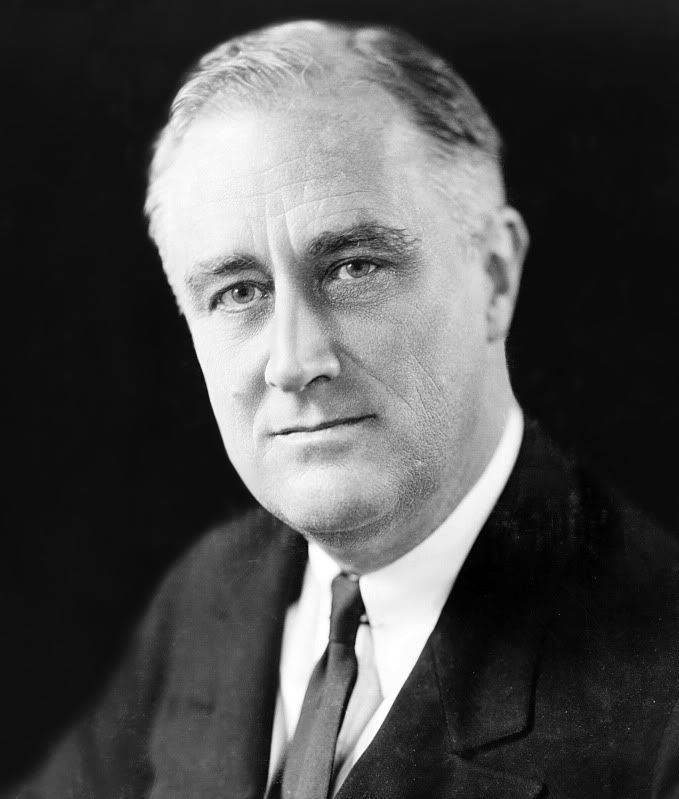

Einstein y...Franklin Delano Roosevelt

La invitación inicial a cenar en

En 1930 se había fundado el Instituto de Estudios Avanzados en Princeton, del que se había hecho cargo su primer director, Abraham Flexner. Contratar a Einstein había sido una maniobra genial (y de suerte) por parte de Flexner, y una que algunas veces el valoró con satisfacción y otras con arrepentimiento. Einstein, el científico más famoso del mundo, le proporcionó al recién fundado Instituto prestigio inmediato, esta era la parte buena para Flexner. Pero Einstein era también el judío vivo más famoso, y esto era malo o, al menos, preocupante para Flexner, él mismo judío. Cuando Albert y Elsa Einstein llegaron al puerto de Nueva York el 17 de octubre de 1933, recibieron una nota de Flexner antes de desembarcar. Decía: “Hay bandas organizadas de nazis irresponsables en este país [...] su seguridad en Estados Unidos depende del silencio y de abstenerse de aparecer en actos públicos”. Flexner había sido advertido por el subsecretario de estado Phillipps de que Einstein debía mantener un perfil bajo, pero Einstein sospechaba que lo que estaba en juego no era tanto su seguridad como la tranquilidad de Flexner.

Flexner abría todo el correo que llegaba al Instituto para Einstein. Fue Flexner el que telefoneó al secretario de prensa de

El encuentro entre los Einstein y los Roosevelt es evidente que fue agradable. Sin embargo, ninguna de las partes comentó demasiado qué había sucedido o de qué se había tratado. Eleanor Roosevelt escribiría a una amiga: “los Einstein llegaron [...] y son únicos, tan alemanes y tan sencillos con muchas sabias y delicadas cualidades alemanas”. Parece ser, por un comentario posterior que habría hecho Elsa, que Roosevelt propuso a Einstein que aceptara una ciudadanía honorífica, tal y como proponían dos miembros del Congreso, pero Einstein habría declinado el trato especial. Einstein sí parece que llegó a conectar a nivel personal con Roosevelt pues, según su amiga Frieda Bucky, habría dicho: “Lamento que Roosevelt sea presidente, de otro modo le visitaría a menudo”.

Si bien este encuentro no tuvo demasiadas consecuencias, el siguiente contacto de Einstein con Roosevelt puso al físico a la vanguardia de la era atómica. Los descubrimientos realizados en 1938 tenían a los físicos alborotados con las posibilidades que podía tener el estudio del uranio. Algunos comentarios de científicos alemanes a sus colegas americanos sobre las nuevas técnicas para romper átomos de uranio y emplear la enorme energía que se liberaría, alarmaban a los que estaban preocupados con la posibilidad de que

Años después, en 1942, con Estados Unidos en guerra tras el ataque japonés a Pearl Harbour en diciembre de 1941, se puso en marcha el proyecto Manhattan, que terminaría con la construcción y detonación de la primera bomba atómica. Aquella carta fue la única contribución, indirecta, al proyecto por parte de Einstein. Su pacifismo y sus “sentimientos filocomunistas” impidieron que el F.B.I. emitiese la autorización para que se le invitase a participar plenamente. Pero esta es otra historia.