Cuando se habla de mejorar nuestro rendimiento intelectual

habitualmente de lo que se discute es de realizar determinados

ejercicios mentales o jugar a algunos videojuegos concretos, cuando

no de llevar tal o cual dieta o tomar suplementos alimenticios,

cuando no fármacos (a este respecto véase Como mejorar elrendimiento intelectual de verdad

). Pero imagínate que todo lo anterior fuese secundario, que hubiese

un dispositivo que pudieses conectar a tu móvil, iPad o PC y que,

efectivamente, mejorase tu capacidad de aprendizaje sin efectos

perniciosos evidentes. Ese dispositivo existe, el que se comercialice

es una cuestión de tiempo y consideraciones éticas.

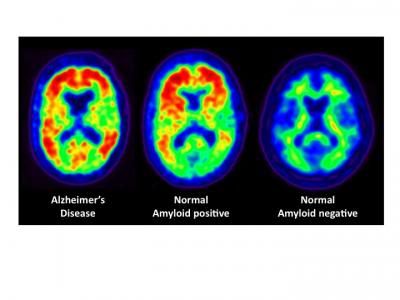

Las investigaciones llevadas a cabo recientemente con distintos

tipos de estimulación encefálica para el tratamiento de pacientes

con patologías neurológicas ha puesto de manifiesto que un tipo de

estimulación cerebral en concreto, llamada estimulación

transcraneal por corriente directa (ETCD), puede usarse para mejorar

las capacidades lingüísticas y matemáticas, la memoria, la

capacidad de resolución de problemas, la atención e, incluso, el

movimiento.

El punto clave es que la ETCD no solamente ayuda a recuperar las

capacidades perdidas. La ETCD puede usarse para mejorar las

capacidades mentales de personas sanas. De hecho, la mayor parte de

las investigaciones se han hecho con adultos sanos.

La ETCD usa unos electrodos que se colocan en el exterior de la

cabeza para pasar pequeñas corrientes a través del encéfalo

durante unos 20 minutos. Las corrientes, de entre 1 y 2 mA

(miliamperios), facilitan la activación de las neuronas de estas

regiones encefálicas. Aunque el mecanismo no está elucidado del

todo, se cree que la estimulación mejora la creación y el

mantenimineto de las conexiones implicadas en el aprendizaje y la

memoria. La técnica es indolora, todo de momento indica que es

segura y que sus efectos se mantienen en el largo plazo.

En caso de comercializarse en un futuro sería un simple

dispositivo que te colocarías en la cabeza poco más o menos como

ahora te pones los auriculares para escuchar música, y que

conectarías a tu ordenador, iPad o similar, cuando te pusieras a

estudiar, a practicar con la guitarra o a aprender malabares.

El diseño básico de un dispositivo para ETCD es muy sencillo, de

hecho se conoce desde hace más de dos siglos. Ya en el siglo XVIII

se realizaron algunos experimentos rudimentarios usando esta técnica

para estudiar la electricidad en animales (humanos incluidos) por

parte de Luigi Galvani y Alessandro Volta. Estos resultados llevaron

a la primera aplicación clínica en 1804 por parte de Giovanni

Aldini (sobrino de Galvani), en la que la técnica mejoraba el estado

de ánimo de pacientes melancólicos. Desafortunadamente este

descubrimiento no recibió mucha atención y no se continuó la

investigación, favoreciendo tratamientos más enérgicos, como los

que derivaron en el electroshock.

En los años 60 del siglo XX hubo un breve resurgimiento del

interés en la ETCD cuando se comprobó que la estimulación podía

afectar al funcionamiento del cerebro cambiando la excitabilidad

cortical. También se descubrió que la estimulación positiva y

negativa tenía diferentes efectos en dicha excitabilidad cortical.

Sin embargo, los efectos más inmediatos y espectaculares de las

drogas así como su simplicidad de uso hicieron que se abandonase de

nuevo la investigación.

No ha sido hasta hace unos 7 años que la ETCD se ha redescubierto

por tercera vez. Esta vez el hallazgo vino por el incremento en el

interés por comprender el funcionamiento del cerebro y como

estimularlo (concretamente la estimulación magnética transcraneal)

y la disponibilidad de nuevas técnicas de imagen como la resonancia

magnética funcional (fMRI).

El número creciente de resultados positivos en los estudios de

primera fase ha llevado a un grupo de investigadores, encabezado por

Roi Cohen Kadosh, de la Universidad de Oxford (Reino Unido), a

plantearse las cuestiones éticas que suscitaría el uso generalizado

de la ETCD. Sus reflexiones aparecen en Current Biology

El artículo incluye consideraciones generales sobre si, de estar

disponible (como parece que estará), debería emplearse un sistema

de mejora de las capacidades cognitivas, si sería ético. El texto

es de acceso libre y está disponible en la referencia al final de

esta entrada, por lo que no vamos a entrar en ese detalle. En vez de

ello vamos a fijarnos en algunos aspectos de esta tecnología que

creemos conviene resaltar y que quizá sean los que merezca la pena

discutir. Desde ya advertimos de que aún no se conocen los

efectos secundarios en general, ni sus consecuencias de uso en el

cerebro de niños.

La ETCD permite a la persona obtener mayor rendimiento del

esfuerzo que pone en una actividad cognitiva. Es decir, no hace

milagros, tendrás que seguir estudiando o practicando pero la

recompensa a tu esfuerzo será mayor.

Es un primer paso en la maximización del potencial humano, pero

no iguala a las personas, al contrario. Lo podrán usar niños,

ancianos, adolescentes o adultos, pero a cada uno según su

capacidad. Probablemente las personas más inteligentes o más

trabajadoras obtengan mayores beneficios que otros. Esto está aún

por determinar. Lo que está claro es que se abrirá una brecha entre

los que tengan acceso a la tecnología y los que no, aunque la

tecnología es muy simple y barata (de hecho habrá que tener cuidado

con los que intenten fabricársela ellos mismos: no

lo hagas en casa).

En principio, y a diferencia de los fármacos, no hay límites

al uso de la ETCD, por lo que puede pensarse que no es algo tan

serio como tomar pastillas, aunque su efectos sean igual de fuertes.

Esta falta de capacidad de limitación externa, como la que tienen

los psicotropos por ejemplo, puede convertir la ETCD en un riesgo

para la salud.

En conclusión, estamos ante lo que puede ser la próxima

revolución cognitiva. En estos momentos se necesita más

investigación para entender mejor los riesgos y beneficios en

poblaciones específicas (niños, ancianos, enfermos, etc.) y en la

vida real, ya que los estudios hechos hasta ahora son relativamente

pocos, a pequeña escala y en laboratorios, pero ello no le resta un

ápice de emoción.

Referencia:

Roi Cohen Kadosh, Neil Levy, Jacinta O’Shea, Nicholas Shea, & Julian Savulescu (2012). The neuroethics of non-invasive brain stimulation Current Biology, 22 (4) PDF