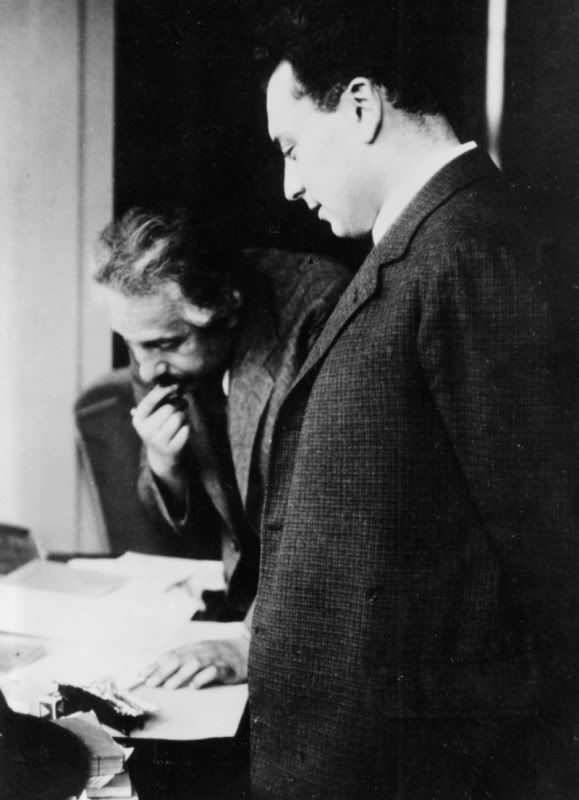

Wolfgang Pauli fue una de las figuras principales en el desarrollo de la mecánica cuántica y su trabajo le valió el premio Nobel de física en 1945. Veinte años más joven que Einstein, colaboró con él cuando ambos trabajaron en Princeton. Pauli tenía una lengua viperina y, si bien respetaba los primeros trabajos de Einstein sobre la relatividad, se mostró muy desdeñoso con sus últimas ideas.

Nacido en Viena (Austria) el 25 de abril de 1900, Pauli estuvo en contacto con la ciencia desde su más tierna infancia. De ello se encargaron su padre químico, Joseph Pauli, y un íntimo amigo de su padre, el físico Ernst Mach, cuyas ideas tanto influyeron en las primeras teorías de Einstein. En el instituto Pauli estudió la teoría de la relatividad especial de Einstein por su cuenta, a menudo escondiendo artículos en su pupitre que leía cuando las clases se volvían inaguantables. Nada más graduarse en el instituto, Pauli publicaría su primer artículo científico, como no podía ser de otra manera, sobre la relatividad de Einstein.

Pauli estudió física en la Universidad de Munich (Alemania), donde rápidamente su genio fue detectado y alentado por Arnold Sommerfeld. Éste, conociendo de lo que era capaz su alumno de doctorado, le pidió que fuese él quien escribiese el artículo sobre la relatividad para la Encyklopaedie der mathematischen Wissenschaften (Enciclopedia de ciencias matemáticas). Dos meses después de presentar su tesis doctoral sobre la teoría cuántica de la molécula de hidrógeno ionizada, presentó el trabajo sobre la relatividad. Nada más y nada menos que 237 páginas en las que describía el estado actual de la teoría así como sus propias interpretaciones. Este artículo dio a conocer a Pauli en el mundo científico. De hecho, a Sommerfeld le gustó tanto que se lo envió al propio Einstein, que alabó el genio de este joven de 21 años. Ciertamente genial, ya que el artículo de Pauli es reconocido hoy día como el catalizador de la cristalización del pensamiento de los investigadores sobre la relatividad.

Una vez finalizado su doctorado, Pauli pasó un año en la Universidad de Gotinga con Max Born, tras el cual investigó junto a Niels Bohr en Copenhague durante otro año. De vuelta en Alemania y mientras era profesor de la Universidad de Hamburgo, en 1924, Pauli completó la que es probablemente su contribución más famosa a la teoría cuántica: el Principio de Exclusión de Pauli. Básicamente, lo que dice el principio es que dos electrones en la órbita de un mismo átomo no pueden tener exactamente el mismo estado energético. Esta afirmación trajo como consecuencia la asignación de una nueva propiedad a los electrones, a la que él denominó “spin”

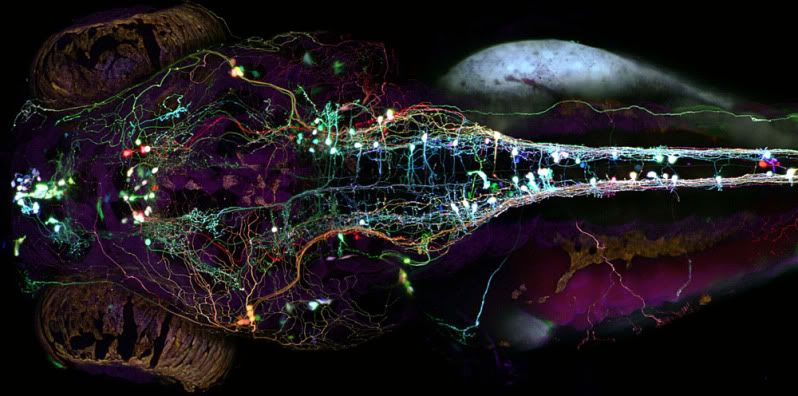

Pauli también es conocido por otra contribución a la física que realizó antes de cumplir los treinta años: predijo la existencia de una partícula fundamental completamente nueva, el neutrino. No fue hasta los años sesenta que la existencia del minúsculo neutrino fue probada de forma concluyente, algo que no vería Pauli, pero que él percibió como una realidad basándose solamente en su necesidad matemática.

Un efecto menos científico también lleva el nombre de Pauli. Parece ser que Pauli tenía la facultad de influir en los experimentos, y en los aparatos necesarios para llevarlos a cabo, de la manera más extraña. Las máquinas se rompían por su mera presencia. Sus amigos se referían a esto como “el efecto Pauli” y Pauli parece que se divertía con su reputación.

Pauli tenía fama de ser un perfeccionista. Existen numerosas referencias a él como la “conciencia de la física”, dado el interés que mostraba en ser el Pepito Grillo del trabajo de sus colegas. Es sabido que Pauli era capaz de los comentarios más mordaces y feroces acerca de la forma de hacer ciencia y de las publicaciones de otros científicos. Una de sus citas más famosas sobre un artículo es “No sólo no es correcto, es que ni siquiera es incorrecto”. A Paul Ehrenfest, por ejemplo, le llegó a decir “Creo que me gustas más tú que tus artículos”.

Einstein tampoco escapó del agudo ingenio de Pauli. Si bien ambos hombres mantenían una relación cordial, Pauli se mofaba a menudo de los intereses científicos de Einstein. Pauli era uno de los muchos científicos que estaba de acuerdo con Niels Bohr en lo que se refería a la mecánica cuántica, aceptando la interpretación dada por Bohr conocida como la interpretación de Copenhague. Einstein, sin embargo, se negaba a admitir que la mecánica cuántica estuviese completa. Estaba decidido a encontrar una nueva teoría que incluyese las matemáticas de la nueva física, que Einstein tenía que admitir que hacían un magnífico trabajo previendo los resultados de los experimentos, y que también las mejorase. Einstein se refería a esta deseada teoría como teoría del campo unificado y Pauli se mostraba desdeñoso con este intento de unir las dos bases fundacionales de la física moderna; le gustaba repetir “Lo que Dios ha separado, el hombre nunca lo unirá”.

En 1932, Pauli escribió una revisión bastante cruel del trabajo sobre la teoría unificada de Einstein, diciendo: “La inventiva inasequible al desaliento de Einstein, así como su tenaz energía en la búsqueda de la unificación, nos garantizan en los años recientes, en promedio, una teoría por año...Es psicológicamente interesante que durante algún tiempo la teoría en vigor es usualmente considerada por su autor como la ‘solución definitiva’”.

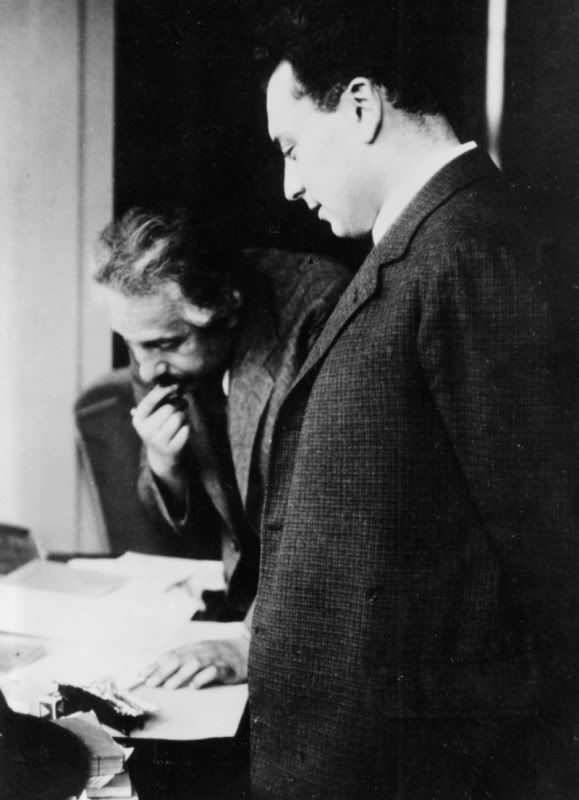

Tras la anexión de Austria por parte de Alemania, Pauli se mudó a Estados Unidos. Trabajó en Princeton entre 1940 y 1946, donde Einstein también tenía su oficina. A pesar del desprecio de Pauli por la teoría de la unificación de Einstein, estaba claro que ambos hombres se respetaban como colegas. Colaboraron solamente en un artículo, en 1943, sobre la teoría de la relatividad.

En enero de 1945 Einstein mandó un telegrama al comité del premio Nobel en el que decía: “Nomino a Wolfgang Pauli para el premio de física stop sus contribuciones a teoría cuántica moderna consistente en así llamado principio de exclusión o Pauli han llegado a ser parte fundamental física cuántica moderna siendo independiente otros axiomas básicos de esa teoría stop Albert Einstein”. Wolfgang Pauli recibió el premio Nobel en la ceremonia de ese año, con 45 años, por el trabajo que hizo cuando tenía 24.

Nota: Wolfgang Pauli no debe ser confundido con Wolfgang Paul, también ganador del Nobel de física y a quien Pauli se refería como “su parte real” (quien sepa matemáticas que entienda).

Referencia:

Einstein, A., & Pauli, W. (1943). On the Non-Existence of Regular Stationary Solutions of Relativistic Field Equations The Annals of Mathematics, 44 (2) DOI: 10.2307/1968759