|

| Cráter Gale, destino de Curiosity |

Cualquier persona mínimamente

interesada en la ciencia sabe que el pasado sábado despegó rumbo a

Marte el

rover Curiosity como parte de la misión Mars Science

Laboratory (MSL) de la NASA. Algunos medios (ejemplos,

aquí

y

aquí) y, en buena medida, el imaginario popular, afirman que el objetivo de

MSL es encontrar “vida” o “rastros de vida”. Pero esto no es

así. Por ello vamos a presentar muy sucintamente no sólo cuales son

los objetivos científicos de MSL sino también el contexto en el que

se han fijado estos objetivos. De esta forma sabremos qué resultados

esperar de MSL y no nos llevaremos decepciones innecesarias.

Objetivos científicos de MSL

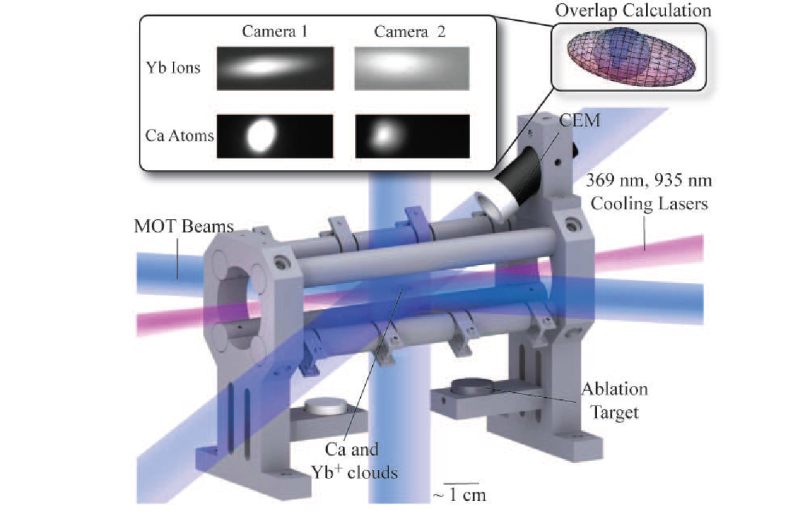

En general, la MSL estudiará si el

cráter Gale presenta signos de ambientes habitables actualmente o en

el pasado. Este estudio será parte de un examen más amplio de los

procesos pasados y actuales en la atmósfera y superficie marcianas.

Para llevarlo a cabo se realizarán mediciones instrumentales

soportadas por la capacidad de recoger muestras, suministrar energía

y comunicaciones y la movilidad del rover Curiosity. Es decir,

no buscará “vida”, sino las condiciones que, según las

hipótesis consideradas, serían favorables para la vida.

Esta misión general se articula en

cuatro objetivos científicos para MSL (entre comillas nuestra

traducción de los objetivos oficiales marcados por la NASA):

a) “Evaluar el potencial biológico

de al menos una ambiente objetivo mediante la determinación de la

naturaleza y el inventario de compuestos de carbono, buscando

específicamente los relacionados con la vida (según la hipótesis

terráquea de que la vida se basa en carbono) e identificando las

características que podrían registrar las acciones de los procesos

biológicamente relevantes”. Es decir, se va a detectar y

cuantificar cualquier molécula orgánica, sobre todo las complejas y

las que podrían ser consecuencia de procesos metabólicos, como el

metano.

b) “Caracterizar la geología del

terreno del rover en todas

las escalas espaciales apropiadas investigando la composición

mineralógica, química e isotópica de la superficie y cercana a la

superficie e interpretar los procesos que han formado las rocas y los

suelos”. Esto es, análisis químico inorgánico exhaustivo.

c)

“Investigar los procesos planetarios de relevancia para la

habitabilidad pasada (incluyendo el papel del agua) mediante la

evaluación de la evolución atmosférica a largo plazo y la

determinación del estado actual, distribución y ciclos del agua y

el dióxido de carbono”. Muy llamativamente no se menciona el

metano.

d) “Caracterizar el espectro completo

de la radiación en superficie, incluyendo la radiación cósmica

galáctica, los sucesos de protones solares y los neutrones

secundarios”

Si nos

damos cuenta a) y b) se resumen en análisis químico cualitativo y

cuantitativo completo del suelo y la atmósfera en, al menos, el

lugar de amartizaje; d) es lo mismo pero de la radiación. Finalmente

c) es registrar los datos de una estación meteorológica. No existe

pues ningún experimento directamente biológico destinado a detectar

vida. Como decíamos más arriba sólo se va a investigar si Marte

fue habitable (según ciertas hipótesis) o lo es hoy día. Si hay

microbios en el lugar de aterrizaje Curiosity no los detectará.

Pero,

¿por qué estos objetivos y no otros?¿Por qué no se incluye ningún

experimento directamente diseñado para detectar vida? La respuesta

corta es por la historia de la exploración de Marte y porque la NASA

no se puede permitir crear falsas expectativas.

Sigue al agua

La hipótesis de que en Marte hay o hubo vida viene de lejos. Una

idea es que como Marte es más pequeño que la Tierra se enfrió

antes y, probablemente, habría podido tener un ambiente compatible

con la vida mucho antes. Por tanto, cabe la posibilidad de que la

vida empezase allí y que los impactos de asteroides arrancasen

trozos de marte que contenían microbios que terminaron llegando a la

Tierra en forma de meteoritos, sembrando la vida. En otras palabras,

descenderíamos de marcianos.

Teorías como esta y otras por el estilo, así como las presuntas

observaciones de canales, etc., dispararon la imaginación de

científicos y literatos sobre la existencia de algo más que simple

vida en Marte.

Pero cuando el Mariner 4, la primera sonda espacial que pasó

cerca de Marte en 1965, mandó fotos de desiertos yermos sólo

salpicados por rocas, los ánimos comenzaron a enfriarse.

Posteriormente las Viking aterrizaron en la superficie del planeta y

realizaron experimentos diseñados espacíficamente para la detección

de vida, con resultados negativos. En 1976 a Marte se le daba ya por

muerto y la enorme inversión en estas dos misiones Viking y las

expectativas defraudadas crearon una enorme decepción en el público y en el gobierno de los Estados Unidos.

A partir de ese momento la NASA ya no jugó tanto con el concepto

de vida en Marte y en vez de ello se embarcó en una campaña

metódica de exploración de la historia geológica y el clima del

planeta. Aunque Marte hoy día parezca seco y frío, lo que se dice

muerto, señales geológicas como rieras, lechos lacustres secos y

cañones gigantescos apuntan a un pasado en el que el agua corría

por la superficie. El lema “sigue al agua” se convirtió en el

principio rector de la exploración. Los dos últimos rovers de la

NASA, Spirit y Opportunity, encontraron pruebas convincentes de que hubo ambientes habitables en el pasado de Marte. El

objetivo de Curiosity es dar un paso más y buscar moléculas basadas

en carbono, incluyendo metano, como posibles bases de una vida

pasada. Suponiendo que ésta se basase en carbono, claro está.

Una actitud conservadora si se quiere, pero es que los datos

disponibles no permiten arriesgar más. No cuando el presupuesto

pende de un hilo y defraudar al contribuyente norteamericano puede

significar la cancelación de programas completos.

Indicios no son pruebas

Imagenes orbitales recientes indicarían que el agua podría estar

fluyendo ocasionalmente en la superficie de Marte. Nuevos hallazgos

realizados en la Tierra acerca de cómo la vida puede florecer en

ambientes aparentemente hostiles, como en la oscuridad de las aguas

cercanas a las fumarolas volcánicas submarinas, ayudan a que los

científicos sean más abiertos a la hora de considerar la posible

pervivencia de la vida en Marte. Pero estos son indicios

circunstanciales, no pruebas.

Las pruebas directas existen pero son, cuando menos,

controvertidas. Así en 1996, un equipo de científicos de la NASA

anunció que había encontrado microbios fosilizados en un meteorito

marciano que había impactado en la Antártida. Esta conclusión fue

discutida inmediatamente por otros grupos de investigadores y aún

hoy se sigue discutiendo casi tanto como la presencia de metano en

Marte. La irregularidad de la presencia de metano en el planeta

podría ser un indicio de la existencia de agua líquida subterránea

o vida, pero aún se discute si la detección es fiable.

Los éxitos de Spirit y Opportunity han permitido que Curiosity

esté de viaje ahora mismo. Pero el reciente fracaso de Phobos-Grunt

no ayuda precisamente a que los dos próximos lander,

proyectos conjuntos NASA-ESA

previstos inicialmente para 2016 y 2018, salgan adelante. De hecho,

el gobierno Obama está seriamente considerando cancelarlos. La

posibilidad de saber si existe vida en Marte puede que tenga que

esperar todavía muchos años.

Más información: