Las compañías farmacéuticas son manifiestamente reservadas, por no decir herméticas. El reloj empieza a contar para una patente en el momento en el que ésta se registra, por lo que cuanto más tiempo se pueda mantener algo en secreto mucho mejor para la cuenta de resultados. Te hueles que pasa algo raro cuando un grupo no menor de estas empresas anuncia que se unen para compartir los resultados de ensayos de fármacos ya abandonados. Y el 11 de junio ocurrió exactamente eso. Hicieron públicos los perfiles de 4000 pacientes de 11 ensayos de tal forma que cada una pudiese aprender de los fallos de la otra. Un acto desinteresado, quizás, pero también uno de desesperación.

La enfermedad de Alzheimer es, tal vez, la enfermedad más asociada con el envejecimiento. Uno espera debilidad física, pero eso se puede afrontar. La debilidad mental es mucho más terrorífica para el que la sufre y mucho más exigente para aquellos que lo tienen que cuidar. También es cara. Los mejores datos se tienen de Estados Unidos, donde el coste estimado es de 170.000 millones de dólares al año. Y se está haciendo más común conforme la gente vive más. Se espera que el número de personas que la padecen se triplique para el 2050. Por tanto, los que la sufren y la sociedad en su conjunto recibirán con entusiasmo un tratamiento efectivo. El fármaco correcto hará ganar a la compañía que lo fabrique cantidades ingentes de dinero. Los incentivos están ahí, pero…

Si uno hace una búsqueda en internet de noticias relacionadas con el Alzheimer tiene la sensación de que la cura está a la vuelta de la esquina, tal cantidad de notas de prensa hay que acaban con un “podría representar una ayuda para comprender mejor cómo curar el Alzheimer” o frase similar. El hecho cierto es que se conoce mucho mejor que hace una década qué pasa en el cerebro del enfermo, pero…

A finales del siglo pasado, la investigación sobre el Alzheimer parecía prometedora. Un aluvión de fármacos que trataban los síntomas de la enfermedad acababa de llegar al mercado y los investigadores se estaban embarcando confiados en la investigación de sus causas últimas. Conociendo éstas, habría una cura, era el mantra repetido. Todavía puede conseguirse, pero la verdad es que no se ha logrado alcanzar el nivel de conocimiento deseado. Como consecuencia se ha acumulado una larga lista de “curas” que han fallado en la última fase de ensayos.

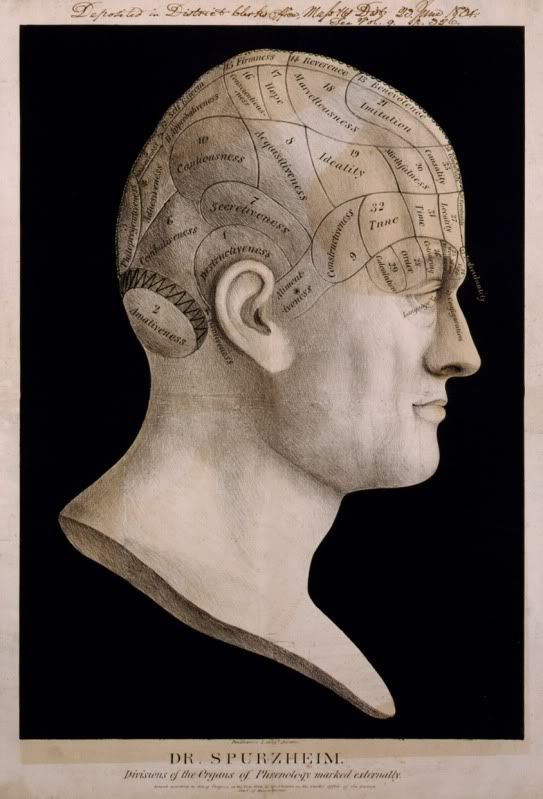

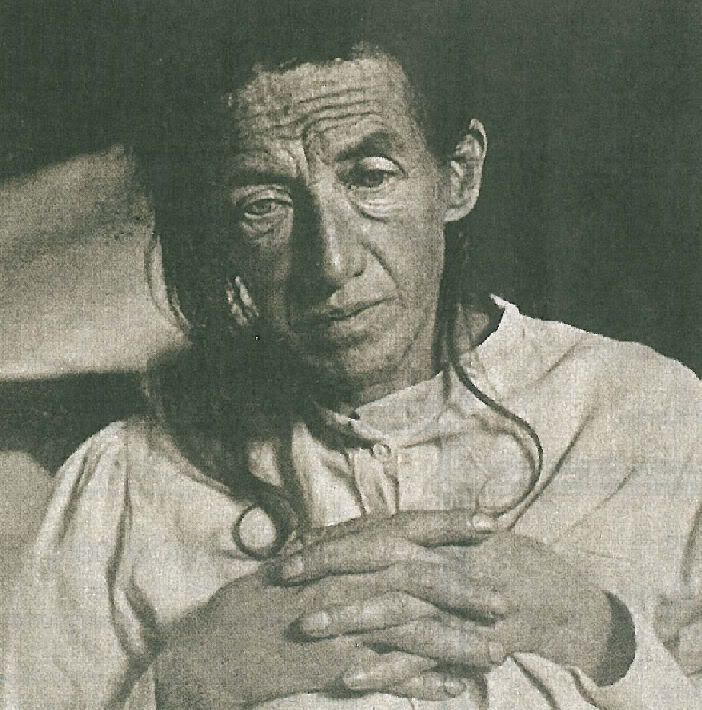

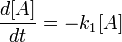

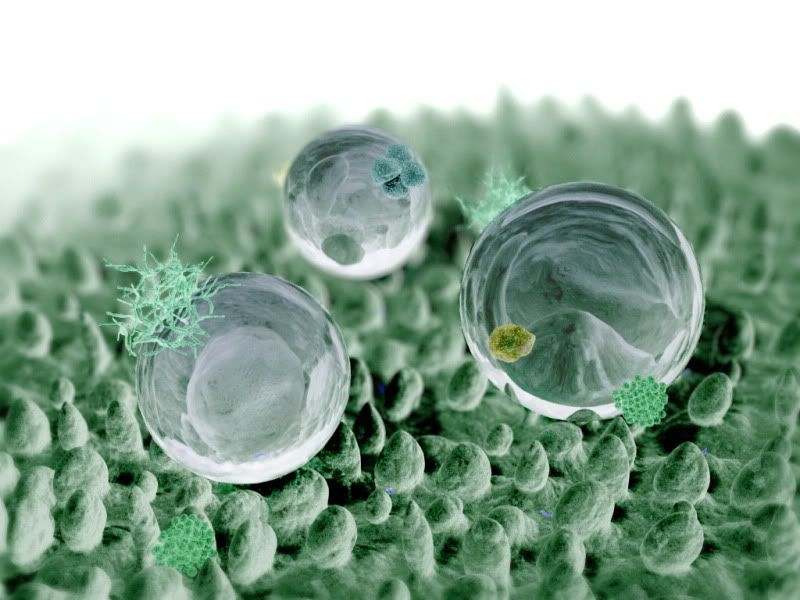

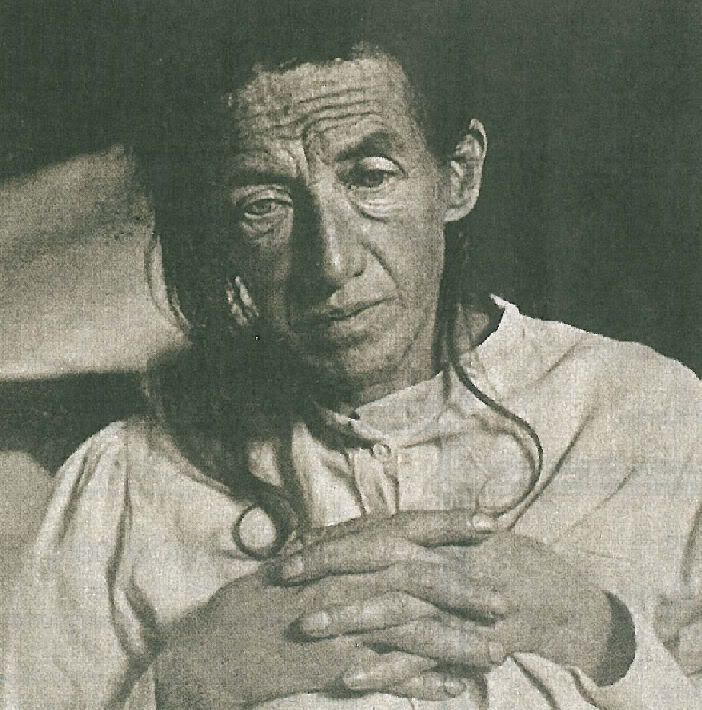

Las manifestaciones físicas de la enfermedad que Alois Alzheimer describió en 1906 son unas placas pegajosas de un tipo de proteína, conocido ahora como beta-amiloide, y unas marañas de un segundo tipo, llamado proteína tau, que envuelven las células nerviosas. Desde 1991 todo el mundo ha dado por buena la hipótesis de que la enfermedad estaba causada por las placas, y que las marañas eran una mera consecuencia. Durante las últimas dos décadas, por tanto, la mayor parte de la atención se ha puesto en desarrollar drogas que eliminen las placas de beta-amiloide del cerebro afectado. Hay cinco fármacos en el mercado que hacen esto, pero solamente retrasan la aparición de la demencia. Una vez que su eficacia se acaba, la pérdida de memoria y el declive cognitivo progresan sin que nada lo impida, y algunas veces hasta se acelera.

En parte por lo anterior, la hipótesis de las placas se está desvaneciendo. La mayor parte de los investigadores aún creen que la beta-amiloide es la culpable, pero la idea de que las responsables son las proteínas que flotan libremente más que las que están en las placas está ganado terreno. Esta idea está apoyada en un estudio publicado en abril en los Annals of Neurology [1], en el que se demostraba que unos ratones sin placas pero con beta-amiloide libre se veían tan debilitados por la enfermedad como los ratones que tenían ambas formas. Si esto también es verdad para las personas, muchos más principios activos, ahora en fase de ensayo, serán ineficaces.

Pero si volvemos los ojos a la prevención la situación no es mucho mejor. El Instituto Nacional de la Salud (NIH, por sus siglas en inglés) de los Estados Unidos acaba de celebrar una conferencia sobre este tema. En las conclusiones podemos leer una declaración del estado de la ciencia, que usarán los médicos como guía a la hora de informar a sus pacientes aunque no constituya la política oficial del NIH. No podía ser más clara y más desalentadora: “Actualmente, no se pueden extraer conclusiones firmes sobre la asociación de cualquier factor de riesgo modificable con el declive cognitivo o con la enfermedad de Alzheimer”. Esto es, la dieta, el ejercicio físico y mental, no fumar, etc. no tendrían capacidad preventiva alguna en lo que respecta al Alzheimer (eso no quita el que esos hábitos son clara y manifiestamente saludables para otros aspectos y están asociados a una vejez de calidad). La genética no es un factor de riesgo modificable, como veremos más abajo.

Esta afirmación del NIH se basa en un estudio realizado por investigadores de la Universidad de Duke (EE.UU.) que se ha publicado en los Annals of Internal Medicine [2]. En esta revisión los autores han analizado décadas de investigaciones, incluyendo tanto estudios observacionales en los que los científicos habían investigado retrospectivamente a un grupo de participantes para revelar asociaciones entre ciertos comportamientos (como el ejercicio) y determinados efectos (como los resultados de unas pruebas de memoria y habilidades cognitivas), como ensayos clínicos en los que se asignaba al azar a los voluntarios a grupos de intervención o de control para después comprobar cómo la intervención afectaba a la capacidad cognitiva. Los autores encontraron que no había suficiente base como para recomendar ni una sola actividad o señalar un factor que actuase como protección frente al deterioro cognitivo cuando uno envejece.

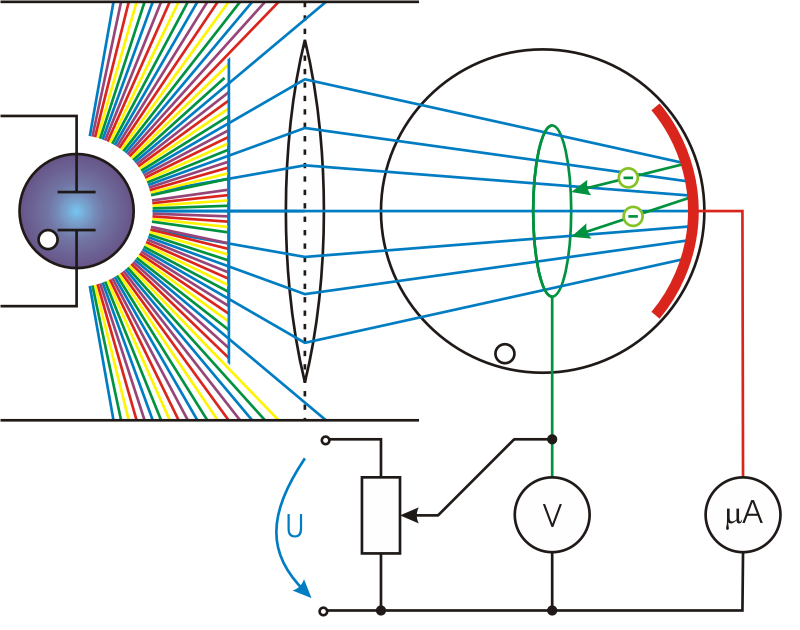

Sea lo que sea lo que produce la enfermedad, y visto que no sabemos cómo prevenirla, se vuelve más interesante el detectarla lo antes posible. Pero esto es otro problema. En el momento en el que alguien presenta síntomas de comportamiento, como que se ha vuelto olvidadizo, su cerebro está ya en un alarmante estado de deterioro. Incluso una “cura” es poco probable que pueda recuperar la función perdida. Por lo tanto sería muy útil disponer de un marcador bioquímico que indicase, mediante un simple análisis, el progreso de la enfermedad, lo que permitiría por una parte identificar a las personas a las que sería aconsejable recomendar el inicio de un tratamiento y, por otra, ayudaría a distinguir a aquellos que sufren Alzheimer de los que padecen otras formas de pérdida de memoria que también vienen con la edad. Y, de no menos importancia, permitiría a los organizadores de ensayos clínicos saber más fácilmente si un fármaco está funcionando.

Con este fin, la Iniciativa de Neuroimágenes de la Enfermedad de Alzheimer (ADNI, por sus siglas en inglés), establecida por el NIH en 2004, está midiendo los niveles de ciertas proteínas en el líquido cefalorraquídeo de personas que podrían tener Alzheimer o terminar teniéndolo. Aunque el proyecto tiene todavía mucho por hacer, ya ha ayudado a desarrollar un ensayo para diagnosticar las primeras etapas de la enfermedad.

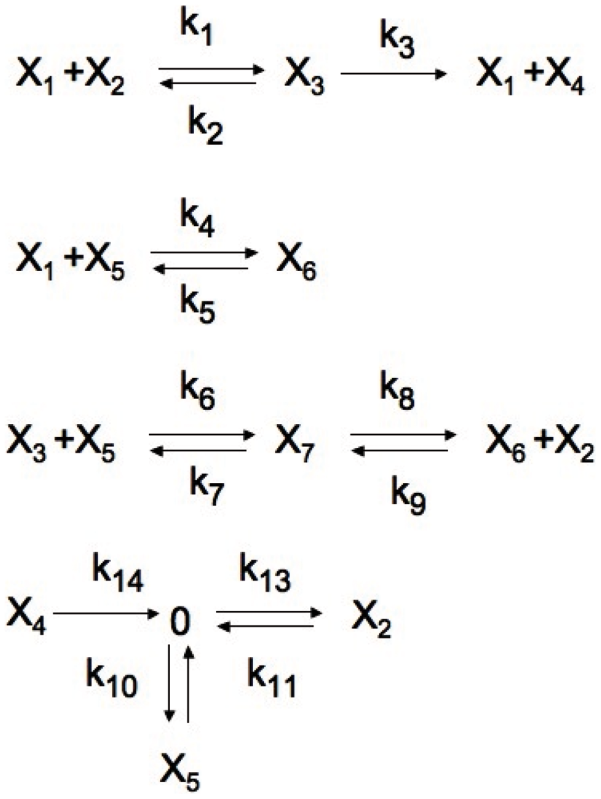

Otro enfoque al problema del biomarcador es el que está adoptando la Red Alzheimer Predominantemente Heredado (DIAN, por sus siglas en inglés), basada en la Universidad Washington en San Luis (EE.UU.). Sus investigadores están estudiando familias con una mutación genética que provoca la aparición del Alzheimer. Este conocimiento terrible significa que es posible predecir qué miembros de una familia están destinados a contraer la enfermedad, y comparar su bioquímica con la de los parientes que no tienen esta mutación.

La confesión de las compañías farmacéuticas, porque es una confesión, indica que el problema sólo tiene una vía de solución, y es la investigación. La I de I+D, la investigación básica. Nunca una inversión fue tan rentable.

Referencias:

[1]

Gandy, S., Simon, A., Steele, J., Lublin, A., Lah, J., Walker, L., Levey, A., Krafft, G., Levy, E., Checler, F., Glabe, C., Bilker, W., Abel, T., Schmeidler, J., & Ehrlich, M. (2010). Days-to-criterion as an indicator of toxicity associated with human Alzheimer amyloid-β oligomers Annals of Neurology DOI: 10.1002/ana.22052

[2]

Plassman BL, Williams JW Jr, Burke JR, Holsinger T, & Benjamin S (2010). Systematic Review: NIH State-of-the-Science Conference: Factors Associated With Risk for and Possible Prevention of Cognitive Decline in Later Life. Annals of internal medicine PMID: 20547887