La experiencia enseña que es mucho más lo que desconocemos que lo que sabemos. También que muchas veces es más interesante el camino que el destino final y que lo verdaderamente revolucionario empieza con un “¡qué curioso!”.

martes, 22 de enero de 2013

Disfrutando a otro nivel

miércoles, 16 de enero de 2013

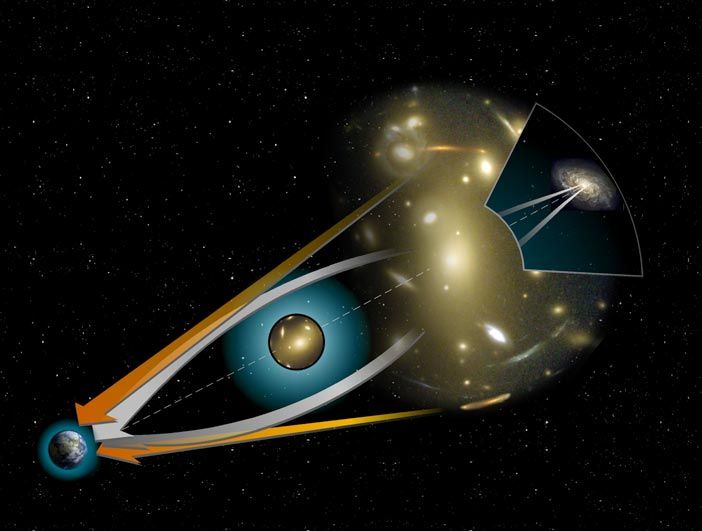

Antilentes gravitacionales: el lado brillante del vacío

Esta entrada es una participación de Experientia docet en la XXXVIII Edición del Carnaval de la Física, que acoge Eureka.

miércoles, 25 de julio de 2012

Nanobiomática, la revolución que marcará el siglo XXI

- La capacidad desarrollada recientemente de secuenciar el ADN rápidamente y en cantidades enormes.

- Las mejoras en microscopia, en el sentido más amplio, desde sistemas de tinción a fotografías a nivel atómico, que permiten una mejor comprensión de los procesos celulares.

- Las técnicas para el estudio específico del encéfalo y su funcionamiento, probablemente el objeto de estudio científico más interesante del universo.

- La asunción generalizada de que la investigación biológica tiene que tener una perspectiva evolutiva.

martes, 7 de febrero de 2012

Peces de pecera, hijos del vacío.

|

| Metaestabilidad |

lunes, 19 de septiembre de 2011

El amoniaco, las nubes frías y la formación de estrellas.

martes, 26 de julio de 2011

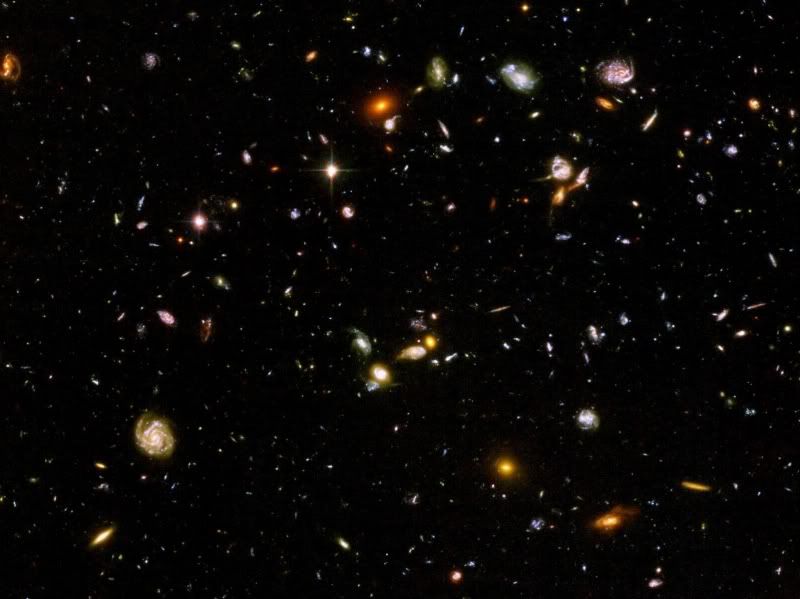

Sin privilegios: confirmación del principio copernicano a escala de gigaparsecs.

|

| Inhomogeneidades a corta distancia en una imagen de campo profundo del Hubble. |

viernes, 1 de julio de 2011

El nuevo límite máximo de escala para la espuma espaciotemporal sacude las teorías de gravedad cuántica.

Referencias:

[1] Laurent, P., Götz, D., Binétruy, P., Covino, S., & Fernandez-Soto, A. (2011). Constraints on Lorentz Invariance Violation using integral/IBIS observations of GRB041219A Physical Review D, 83 (12) DOI: 10.1103/PhysRevD.83.121301

[2] Abdo, A., et al. (2009). A limit on the variation of the speed of light arising from quantum gravity effects Nature, 462 (7271), 331-334 DOI: 10.1038/nature08574

lunes, 27 de junio de 2011

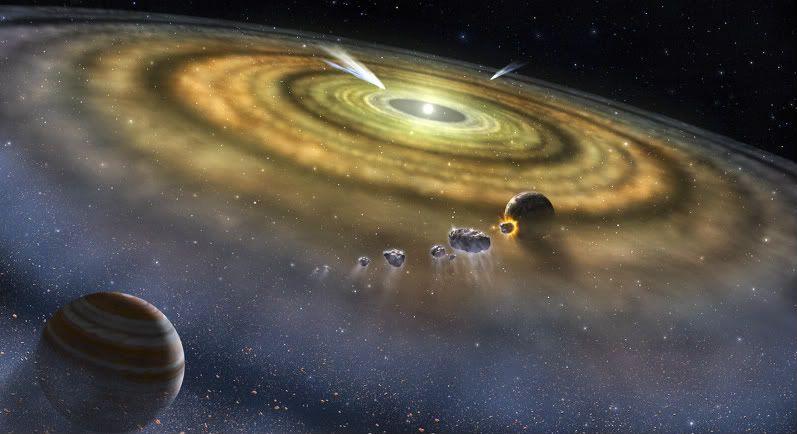

¿De dónde vino el nitrógeno pesado de la Tierra?

Referencias:

[1] Marty, B., Chaussidon, M., Wiens, R., Jurewicz, A., & Burnett, D. (2011). A 15N-Poor Isotopic Composition for the Solar System As Shown by Genesis Solar Wind Samples Science, 332 (6037), 1533-1536 DOI: 10.1126/science.1204656

[2] McKeegan, K., Kallio, A., Heber, V., Jarzebinski, G., Mao, P., Coath, C., Kunihiro, T., Wiens, R., Nordholt, J., Moses, R., Reisenfeld, D., Jurewicz, A., & Burnett, D. (2011). The Oxygen Isotopic Composition of the Sun Inferred from Captured Solar Wind Science, 332 (6037), 1528-1532 DOI: 10.1126/science.1204636

jueves, 7 de octubre de 2010

La brillante idea del Dr. Hawking

En 1974 Stephen Hawking llegó al convencimiento teórico de que los agujeros negros no podían ser negros, si acaso gris muy oscuro. Un agujero negro se dice que es negro porque se supone que nada, ni siquiera la luz, puede escapar de su atracción gravitatoria. Según Hawking, sin embargo, debido a una de esas rarezas de la mecánica cuántica, un agujero negro debería brillar muy muy débilmente, como los rescoldos en una hoguera a punto de apagarse. Las implicaciones eran tremendas. Al emitir, la que dio en llamarse radiación de Hawking, un agujero negro iría perdiendo gradualmente energía y masa. Si no consigue incorporar más masa terminaría evaporándose completamente, como un charco en un cálido día de verano.

El problema del resultado de Hawking es que, como corolario, predecía que la temperatura típica a la que un agujero negro emite radiación debería ser del orden de una milmillonésima de la radiación de fondo que dejó el mismísimo Big Bang. Por tanto, la comprobación experimental observando la radiación emitida por un agujero negro es imposible, hoy por hoy, en la práctica.

En un artículo [1] subido a arXiv, y aceptado para publicación en Physical Review Letters, un equipo de investigadores dirigido por Daniele Faccio de

Pero, ¿qué tiene que ver una cosa con la otra? ¿Cómo se relaciona lo que ocurre en un trozo de vidrio en la mesa de un laboratorio con uno de los objetos más espectaculares del universo?

Si una estrella moribunda tiene masa suficiente, puede colapsar y formar una región de densidad infinita llamada singularidad. La gravedad de un objeto así es tan intensa que nada, ni siquiera la misma luz, puede librarse de ella si se le ocurre pasar lo suficientemente cerca de él. El límite a partir del cual ya no hay escape se llama horizonte de sucesos.

En el año 1974 Hawking se paró a considerar qué pasaba justo en el borde del horizonte de sucesos. Según la mecánica cuántica, el espacio vacío es cualquier cosa menos vacío. Más bien es un caldero en ebullición de partículas evanescentes. Durante breves períodos de tiempo, estas partículas pasan a la existencia desde la pura nada, dejando atrás agujeros en la nada. Estos agujeros son sus antipartículas. Poco tiempo después, la partícula y su agujero se recombinan, y vuelve la nada.

Si resulta que el par partícula-agujero aparece en el borde de un horizonte de sucesos, puede ocurrir que la partícula o su agujero crucen el horizonte de sucesos para nunca más volver. Al otro componente del par no le queda otro remedio que hacerse real. Estas partículas, la mayor parte de las cuales son fotones, son las que constituyen la radiación de Hawking, y como los fotones y los antifotones son iguales, los agujeros contribuyen de la misma manera que las partículas.

Pero ¿de dónde viene la energía de estos fotones que han surgido de la nada? Del mismo agujero negro, que de esta forma se evapora gradualmente. La radiación de Hawking une campos tan aparentemente inconexos como la gravitación, la mecánica cuántica y la termodinámica, convirtiéndose por ello un concepto importante de la física teórica de los últimos 30 años.

En 1981 este concepto se vio ampliado. William Unruh de

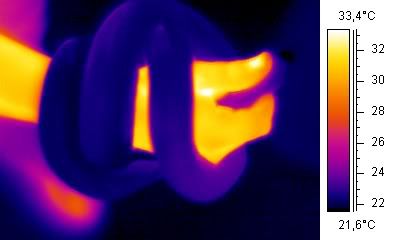

Lo que el equipo de Faccio ha sido capaz de hacer es una versión de este fenómeno en la que intervienen fotones. Se basan en que, conforme el pulso de luz láser se mueve a través de la pieza de vidrio (sílice fundida), cambia el índice de refracción del mismo (la velocidad a la que la luz se mueve a través del material) por tratarse de un medio no lineal (para saber por qué ocurre esto se puede leer a Migui o a Francis). La luz en la proximidad del pulso se ve más y más ralentizada conforme el índice de refracción va cambiando con el paso del pulso.

Para ver cómo un pulso “A” puede actuar como un agujero negro, imagina que lo enviamos tras otro más débil y lento, “B”. Poco a poco A va alcanzando a B, reduciendo la velocidad de la luz en las proximidades del pulso lento, B. Esto ralentizará aún más el pulso lento B hasta que finalmente se desacelere tanto que se pare. Básicamente, el frente del pulso perseguidor A lo ha “capturado”, actuando como el horizonte de sucesos de un agujero negro.

Ahora imagina que enviamos otro pulso “C” tras el A, pero C es más débil. Conforme C se acerca a la cola de A también reduce la velocidad (porque la velocidad de la luz en el vidrio que está atravesando ha sido reducida por el paso de A). Cuanto más se acerca, más lento viaja, y nunca puede terminar de alcanzarlo. La cola de A se ha convertido también, por tanto, en otro horizonte de sucesos. En este caso, sin embargo, impide que las cosas entren más que evitar que salgan. Parece la antítesis de un agujero negro, por lo que podemos llamarlo un agujero blanco.

En el experimento llevado a cabo, no había pulsos B ni C. Su papel lo representaban los fotones evanescentes que surgían de la nada alrededor de A. Conforme el pulso pasaba a través del vidrio, sus horizontes de sucesos podrían haber “barrido” algunos de estos fotones, produciendo la radiación de Hawking con los que dejaban atrás.

Cuando el equipo de investigadores enfocó la cámara y disparó 3600 pulsos del láser, registró un débil resplandor precisamente en el rango de frecuencias que la teoría de Hawking predice. Tras una cuidadosa consideración y descarte de otras posibles fuentes para esta luz, concluyen que han observado realmente la radiación de Hawking por primera vez.

Aunque estos estudios no pueden probar con certeza que los agujeros negros emiten radiación y se evaporan, sí apoyan las ideas que usó Hawking en su razonamiento.

Referencias:

[1]

F. Belgiorno, S. L. Cacciatori, M. Clerici, V. Gorini, G. Ortenzi, L. Rizzi, E. Rubino, V. G. Sala, & D. Faccio (2010). Hawking radiation from ultrashort laser pulse filaments Physical Review Letters arXiv: 1009.4634v1domingo, 19 de septiembre de 2010

La falta de rigor en la comunicación de la ciencia: el caso del magnetar en Westerlund 1

Los antecedentes:

En 2005 un equipo de astrónomos encabezado por Michael Muno [1] [2] [3] encontró lo que supone una pega a este cuadro de la evolución estelar. Esta pega tenía forma de magnetar. Los magnetares son un tipo de estrellas de neutrones que tienen un campo magnético del orden de 10 gigateslas, 1 billón (billón español, 1 millón de millones) de veces más intenso que el de la Tierra. Aunque son raras, encontrar una magnetar no debería suponer mucho revuelo pero es que el magnetar en cuestión debería haber sido un agujero negro dada la masa calculada para la estrella progenitora, 40 MS.

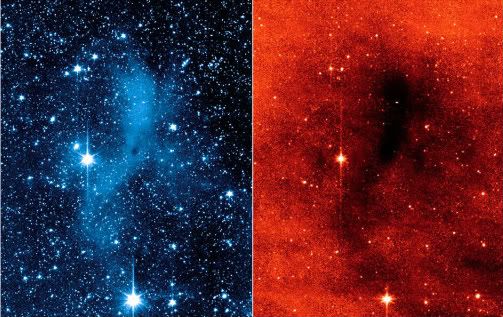

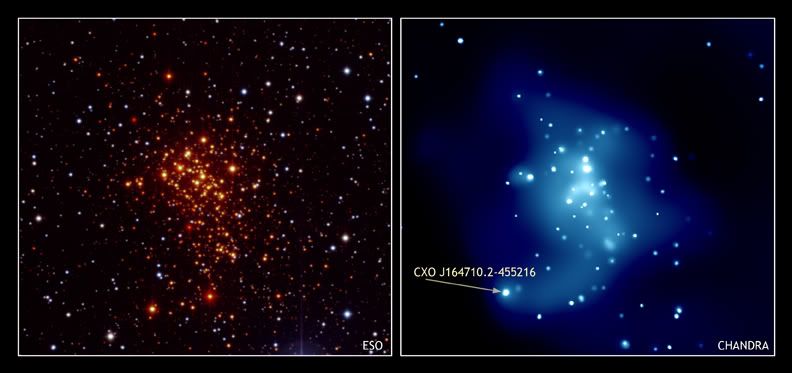

El magnetar se encuentra en un cúmulo de estrellas llamado Westerlund 1 [en la imagen, a la izquierda en visible -ESO-, a la derecha en rayos X -Chandra- con el magnetar marcado], a unos 16.000 años-luz de la Tierra. Estudios anteriores habían demostrado que éste es el más próximo de los llamados supercúmulos estelares, colecciones de cientos de estrellas brillantes y masivas, todas nacidas a la vez. En el caso de Westerlund 1, se calcula que su nacimiento tuvo lugar hace entre 3,5 y 5 millones de años.

La noticia:

Un equipo encabezado por Simon Clark, usando observaciones del VLT (Very Large Telescope) del Observatorio Europeo Austral (ESO, por sus siglas en inglés) del sistema doble eclipsado W13 de Westerlund 1 ha podido calcular las masas de las estrellas que lo componen. Como todas las estrellas de Westerlund 1 nacieron a la vez, este dato supone un límite inferior para la masa del magnetar ya que, al ser la vida de una estrella inversamente proporcional a su masa, la que dio origen al magnetar tuvo la vida más corta (ha sido la primera en evolucionar) y, por tanto, era la de mayor masa del cúmulo. Este resultado [4] supone una confirmación del dato calculado en 2005.

La comunicación:

La oficina de prensa de ESO mezcla pasado y presente en su comunicado de prensa [5], eso sí enfatizando la participación de científicos europeos. Afirma:

“Utilizando el Very Large Telescope (VLT) de ESO en el norte Chile, astrónomos europeos han demostrado por primera vez que un magnetar -un inusual tipo de estrella de neutrones- se formó a partir de una estrella de al menos 40 veces la masa del Sol. El resultado desafía las actuales teorías sobre evolución estelar pues se esperaba que una estrella tan masiva como ésta se convirtiera en un agujero negro, no en un magnetar. Esto genera una pregunta fundamental: ¿cuán masiva tiene que ser realmente una estrella para convertirse en un agujero negro? “

La falta de rigor (por no hablar de abierta manipulación) es evidente, el trabajo de Clark et al. confirma el de Muno de hace 5 años y, como demuestra la lectura de los enlaces, no aporta ningún dato nuevo aparte del método empleado.

Lamentablemente la información se propaga sin ser contrastada tanto en blogs [6] [7] [8] [9] [10] (estos son sólo ejemplos, con algunos desbarrando completamente cuando se salen del guión), como en la prensa profesional [11] [12] que encima, con eso de querer ser originales, titulan sin sentido.

Durante un debate con Roger Penrose en 1994 en el Instituto de Ciencias Matemáticas Isaac Newton de la Universidad de Cambridge (Reino Unido), Stephen Hawking dijo: “ Einstein estaba equivocado cuando dijo que dios no juega a los dados. La consideración de los agujeros negros sugiere que dios no sólo juega a los dados, sino que algunas veces nos confunde tirándolos donde no se pueden ver.” Visto lo visto, otras veces somos nosotros los que les damos una patada para que vayan debajo del sofá.

[1]

Muno, M., Clark, J., Crowther, P., Dougherty, S., de Grijs, R., Law, C., McMillan, S., Morris, M., Negueruela, I., Pooley, D., Portegies Zwart, S., & Yusef-Zadeh, F. (2006). A Neutron Star with a Massive Progenitor in Westerlund 1 The Astrophysical Journal, 636 (1) DOI: 10.1086/499776miércoles, 1 de septiembre de 2010

¿Varía espacialmente la constante de estructura fina?

clocks, Oklo, meteorites, and cosmological phenomena Physical Review Letters arXiv: 1008.3957v1

miércoles, 11 de agosto de 2010

Un metamaterial para observar qué ocurre cuando cambia la geometría del espaciotiempo.

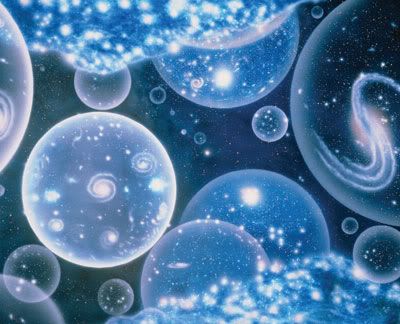

Según algunos teóricos, en el momento del Big Bang, nuestro universo puede que no tuviese exactamente tres dimensiones espaciales y una temporal. Igor Smylianinov, de la Universidad de Maryland (EE.UU.), y Evgenii Narimanov, de la Universidad Purdue (EE.UU.), proponen en Physical Review Letters una forma de observar la transición hacia nuestro universo usando los llamados metamateriales, estructuras en las que la propagación de la luz puede ser controlada de forma precisa. Según estos autores, los experimentos en estas estructuras podrían confirmar las predicciones de que un gran flash de radiación acompañaría a los cambios en la estructura del espaciotiempo que podrían haber tenido lugar en el universo primitivo.

A lo largo de la última década se ha profundizado en el conocimiento de los materiales en los que se pueden manipular las propiedades eléctricas y magnéticas a nivel microscópico. Este conocimiento ha llevado a poder hablar por ejemplo de que, en un futuro no demasiado lejano, podrán construirse dispositivos como lentes perfectas o capas de invisibilidad. Algunos resultados se han obtenido ya en esta dirección experimentalmente usando metamateriales, pequeños cables, anillos y otras estructuras que son del orden de magnitud de la longitud de onda de la luz.

Según Smolyaninov y Narimanov estos materiales adaptados podrían usarse para explorar geometrías no habituales del espaciotiempo. Usualmente cuando una onda luminosa atraviesa un material, si la longitud de onda se acorta, su frecuencia aumenta, y esto en todas direcciones igualmente. Pero estos autores describen un metamaterial en el que la relación entre frecuencia y variaciones espaciales de los campos electromagnéticos es muy anisotrópica, es decir, varía mucho con la dirección que se considere. Para algunas configuraciones de campos, se podría incrementar la longitud de onda efectiva en una dirección concreta y la frecuencia global seguiría disminuyendo.

En este artículo los autores afirman demostrar que esta, así la llaman, relación hiperbólica entre las variaciones espaciales y temporales de las ondas electromagnéticas es exactamente la misma que se obtendría en un espaciotiempo que tuviese dos dimensiones temporales y dos espaciales. Una propiedad de esta geometría sería que, para una frecuencia dada, existe un número infinito de modos del campo electromagnético, mientras que en el espaciotiempo “normal” podría haber muchos, pero no un número infinito.

Los investigadores advierten de que estos materiales no permitirían cosas “raras” como máquinas del tiempo (una posibilidad teórica si tienes dos dimensiones temporales), porque las frecuencias a las que tiene lugar el fenómeno son muy limitadas y se ve impedido por las pérdidas de energía, que no se consideran en la teoría. Pero la manipulación de estos materiales sí podría permitir a los experimentadores observar qué ocurre cuando la geometría del espaciotiempo cambia sustancialmente. Por ejemplo, si las muchas dimensiones extras de la teoría de cuerdas se hubiesen “enrollado” repentinamente en el universo primitivo, dejando sólo tres dimensiones espaciales, algunos teóricos afirman que se habría producido un gran flash de radiación, de alguna forma similar al Big Bang. Este flash habría ocurrido porque toda la energía de los infinitos modos en el espaciotiempo de mayores dimensiones se habría liberado de repente.

Smolyaninov y Narimanov proponen construir una estructura que incluya capas de finos cables de galio, que se hace más conductor cuando se funde un poco por encima de la temperatura ambiente. Según sus cálculos, la fusión cambiaría el metamaterial de normal a hiperbólico, por lo que se podría observar un gran flash mientras se enfría.