Los recientes Premios de la Academia (Oscars) a la película “El discurso del rey” (The King's Speech) nos van a servir de excusa para repasar, sin ánimo de ser exhaustivos, el estado de la cuestión en lo que se refiere a la tartamudez, lo que a su vez nos permitirá comprobar (por si alguien lo dudaba) que lo que funciona en las películas no tiene por qué tener relación alguna con la realidad.

A lo largo de la historia se ha atribuido la tartamudez a muchas causas diferentes. Galeno decía que era consecuencia de una sequedad de la lengua. En el siglo XVII, Francis Bacon decía que era consecuencia de una rigidez de la lengua. En el siglo XIX, los cirujanos sugerían que se debía a una lengua demasiado larga. En el siglo XX irrumpen las explicaciones “psicológicas”, desde una desatención por parte de los padres hasta una necesidad no saciada de sexo oral (“El discurso del rey” resalta el aspecto psicológico). Los remedios propuestos, obviamente, han sido igual de variados. Galeno pensaba que era necesario envolver la lengua en una tela empapada en zumo de lechuga. Bacon recomendaba la ingesta de vino. Los cirujanos del XIX afirmaban que era necesario usar el bisturí. Los psiquiatras, el diván. Pero ninguno de estos remedios funciona (excepto en las películas).

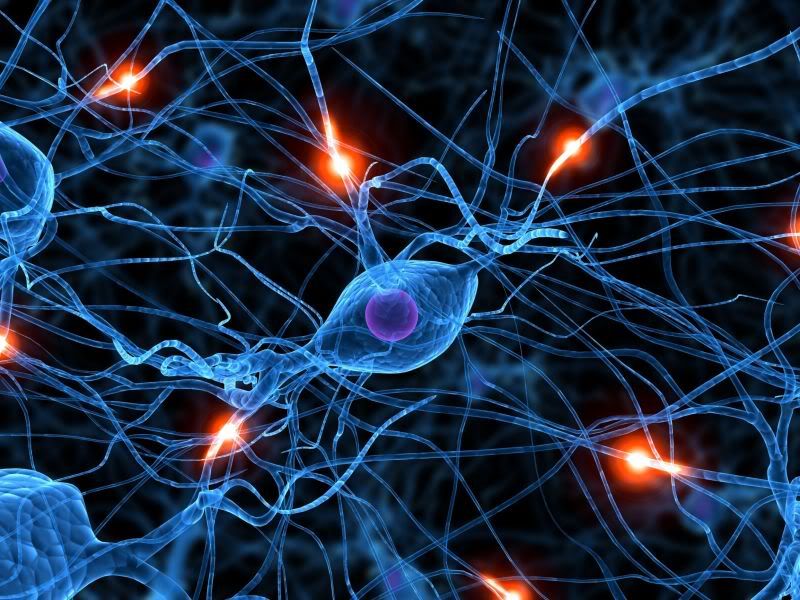

El uso de la tomografía por emisión de positrones y las imágenes por resonancia magnética funcional [1][2] ha puesto de manifiesto que aquellas partes del cerebro que suelen asociarse a la producción del habla están más activas en los tartamudos que en lo que no lo son, mientras que aquellas otras relacionadas con las percepción de los sonidos lo están menos. Además, los dos tipos de cerebro tienen un aspecto diferente. Los tartamudos parecen tener una materia gris más densa en las áreas asociadas con el procesamiento y la producción de sonidos. Pero unas diferencias así deben tener causas más profundas.

Y muy probablemente esas causas sean mayoritariamente genéticas. Los estudios con gemelos ponen de manifiesto que la disfemia (otro nombre para la tartamudez) tiene un componente genético mayor que los conocidos para el colesterol alto y la osteoporosis, por ejemplo. Al menos dos estudios con niños adoptados sugieren que aquellos cuyos padres adoptivos tartamudean no tienen más probabilidad de desarrollar disfemia que aquellos adoptados por no-tartamudos.

Para descubrir qué genes podrían estar implicados un reciente estudio [3] se centró en 44 familias pakistaníes. Los matrimonios entre primos es bastante común en Pakistán, y esta endogamia lleva a una alta incidencia de las afecciones de origen genético. El análisis sugiere que la disfemia está asociada a una mutación del gen GNPTAB, un dato que después fue confirmado cuando la misma mutación fue descubierta en un grupo de tartamudos procedentes de familias no relacionadas con las anteriores de origen pakistaní e hindú. Investigaciones posteriores [4] han puesto de manifiesto que esta mutación ocurrió hace 572 generaciones en un ancestro común, que habría vivido hace 14.000 años.

Existen además otros dos genes , GNPTG y NAGPA, que se encuentran en personas que tartamudean pero no en no-tartamudos. Los tres genes afectados codifican enzimas que regulan los lisosomas, las unidades de gestión de desechos de las células. Dos de las mutaciones también aparecen como causa de una rara enfermedad llamada mucolipidosis. La mucolipidosis severa es mortal en los primeros diez años de vida. Incluso la forma más leve tiene síntomas graves: desarrollo anormal del esqueleto y, algunas veces, un ligero retraso mental.

Sin embargo, no se aprecian síntomas de mucolipidosis en los tartamudos. Una explicación sería que ambas afecciones estarían relacionadas con un plegamiento inadecuado de las enzimas en cuestión (el plegamiento es crítico en cualquier proteína para que cumpla correctamente su función), pero que los detalles de esa inadecuación del plegamiento serían diferentes. Una hipótesis sería pues que un grupo específico de células cerebrales implicadas en la producción del habla sería selectivamente sensible, por una razón desconocida, a ese sutil fallo enzimático, produciendo, quizás, los patrones que se ven en los escáneres de los que hablábamos más arriba.

Hoy día existen varios grupos trabajando en los detalles de las causas de la disfemia. Esperemos que sus hallazgos permitan obtener tratamientos que sean más efectivos que el zumo de lechuga o el vino. Lo demás, son películas.

Referencias:

[1]

[2]

Beal DS, Cheyne DO, Gracco VL, Quraan MA, Taylor MJ, & De Nil LF (2010). Auditory evoked fields to vocalization during passive listening and active generation in adults who stutter. NeuroImage, 52 (4), 1645-53 PMID: 20452437

[3]

Kang C, Riazuddin S, Mundorff J, Krasnewich D, Friedman P, Mullikin JC, & Drayna D (2010). Mutations in the lysosomal enzyme-targeting pathway and persistent stuttering. The New England journal of medicine, 362 (8), 677-85 PMID: 20147709

[4]

Fedyna A, Drayna D, & Kang C (2011). Characterization of a mutation commonly associated with persistent stuttering: evidence for a founder mutation. Journal of human genetics, 56 (1), 80-2 PMID: 20944643